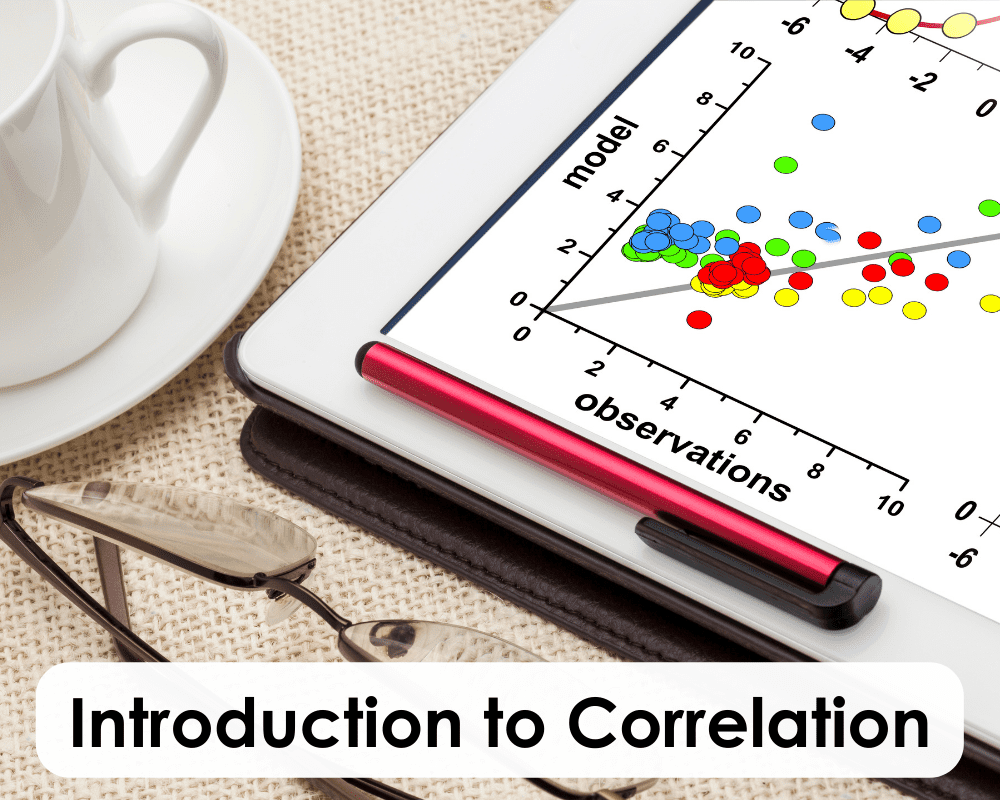

Scalare l’apprendimento audio-visivo senza etichette

Scaling unsupervised audio-visual learning

Una nuova tecnica multimodale fonde i principali metodi di apprendimento auto-supervisionato per imparare in modo più simile agli esseri umani.

Ricercatori del MIT, del MIT-IBM Watson AI Lab, di IBM Research e altrove hanno sviluppato una nuova tecnica per analizzare dati audio e visivi non etichettati che potrebbe migliorare le prestazioni dei modelli di apprendimento automatico utilizzati in applicazioni come il riconoscimento vocale e il rilevamento di oggetti. Il lavoro, per la prima volta, combina due architetture di apprendimento auto-supervisionato, apprendimento contrastivo e modellizzazione di dati mascherati, nel tentativo di scalare compiti di apprendimento automatico come la classificazione degli eventi nei dati unimodali e multimodali senza la necessità di annotazione, replicando così il modo in cui gli esseri umani comprendono e percepiscono il nostro mondo.

“Una porzione maggiore della conoscenza umana è appresa in modo auto-supervisionato, perché non sempre riceviamo segnali di supervisione e vogliamo consentire al modello di apprendimento automatico di avere la stessa capacità”, afferma Yuan Gong, un postdoc del MIT nel Laboratorio di Informatica e Intelligenza Artificiale (CSAIL).

- I ricercatori del MIT rendono i modelli di linguaggio autoapprendenti scalabili.

- Portare le responsabilità sociali ed etiche dell’informatica in primo piano

- Incontra ChatDB un framework che aumenta gli LLM con memoria simbolica sotto forma di database.

“Quindi, un altro modo per dirlo è che l’apprendimento auto-supervisionato spesso forma la base di un modello iniziale, perché può apprendere su vasti quantitativi di dati non etichettati. E poi puoi usare l’apprendimento supervisionato o l’apprendimento per rinforzo per regolare ulteriormente il modello su qualcosa di particolare se lo desideri”, afferma Jim Glass, un ricercatore senior del MIT e membro del MIT-IBM Watson AI Lab.

La tecnica, chiamata autoencoder mascherato audio-visivo contrastivo (CAV-MAE), è un tipo di rete neurale che può imparare ad estrarre e mappare rappresentazioni latenti significative in uno spazio ad alta dimensionalità da dati acustici e visivi mediante l’addestramento su grandi insiemi di dati di clip audio e video di 10 secondi di YouTube. I ricercatori affermano che la tecnica è più efficace rispetto agli approcci precedenti perché modella esplicitamente le relazioni tra i dati audio e visivi in un modo che altri metodi non fanno.

Fanno parte dello studio Gong e Glass, insieme agli studenti Andrew Rouditchenko e Alexander H. Liu del MIT, David Harwath PhD ’18 dell’Università del Texas ad Austin e ai membri del MIT-IBM Watson AI Lab Leonid Karlinsky e Hilde Kuehne. Kuehne è anche affiliato con l’Università Goethe di Francoforte. Il metodo è stato recentemente presentato alla Conferenza Internazionale sulla Rappresentazione dell’Apprendimento.

Un approccio congiunto e coordinato

CAV-MAE funziona attraverso “l’apprendimento mediante predizione” e “l’apprendimento mediante confronto”, afferma Gong. La modellizzazione di dati mascherati, o il metodo di predizione, prende un video insieme alla sua forma d’onda audio coordinata, converte l’audio in uno spettrogramma e maschera il 75% di entrambi. I dati non mascherati vengono tokenizzati, quindi alimentati in encoder audio e visivi separati prima di entrare in un codificatore/decodificatore congiunto, dove il modello viene chiesto di recuperare i dati mancanti. La differenza (perdita di ricostruzione) tra la predizione ricostruita risultante e la combinazione audio-visiva originale viene quindi utilizzata per addestrare il modello per una migliore performance. Un esempio di questo sarebbe coprire parte di un video di un pianoforte e parte di uno spettrogramma di musica per pianoforte, e poi chiedere al modello di cercare di determinare gli input mascherati. Purtroppo, questo metodo potrebbe non catturare l’associazione tra la coppia video e audio, mentre l’apprendimento contrastivo sfrutta questo, ma potrebbe scartare alcune informazioni uniche per la modalità, come lo sfondo in un video.

L’apprendimento contrastivo mira a mappare rappresentazioni che sono simili tra loro. Ad esempio, il modello cercherà di posizionare diversi dati video e audio di diversi pappagalli vicini tra loro e lontani da coppie di video e audio di chitarre che suonano. In modo simile all’autocodifica mascherata, le coppie audio-visive vengono trasmesse in encoder di modalità separate; tuttavia, i componenti audio e visivi sono tenuti separati all’interno del codificatore congiunto prima che il modello esegua il pooling e la perdita contrastiva. In questo modo, l’apprendimento contrastivo cerca di identificare le parti di ciascun audio o video che sono più rilevanti per l’altro. Ad esempio, se un video mostra qualcuno parlare e la clip audio corrispondente contiene discorsi, l’autocodificatore imparerà ad associare i movimenti della bocca del parlante con le parole pronunciate. Regolerà quindi i parametri del modello in modo che quegli input siano rappresentati vicini tra loro. In definitiva, il metodo CAV-MAE combina entrambe le tecniche con più flussi di dati in avanti con mascheramento come primo passaggio, encoder specifici della modalità e normalizzazione del livello in modo che le forze di rappresentazione siano simili.

“Abbiamo quindi voluto confrontare il proposto CAV-MAE con un modello addestrato solo con un autoencoder mascherato e un modello addestrato solo con apprendimento contrastivo, perché vogliamo mostrare che combinando autoencoder mascherato e apprendimento contrastivo, possiamo ottenere un miglioramento delle prestazioni”, afferma Gong, “e i risultati supportano la nostra ipotesi che ci sia un miglioramento evidente”.

I ricercatori hanno testato CAV-MAE, così come il loro metodo senza perdita contrastiva o un autoencoder mascherato, contro altri metodi all’avanguardia su compiti di recupero audio-visivo e classificazione degli eventi audio-visivi utilizzando set di dati AudioSet standard (20K e 2M) e VGGSound – clip realistiche etichettate, che potrebbero includere suoni multipli. Il recupero audio-visivo significa che il modello vede solo il componente audio o visivo di una coppia di query e cerca quello mancante; la classificazione degli eventi include l’identificazione di azioni o suoni all’interno dei dati, come una persona che canta o una macchina che guida.

In generale, hanno scoperto che l’apprendimento contrastivo e la modellizzazione dei dati mascherati sono metodi complementari. CAV-MAE è riuscito a superare le tecniche precedenti (con pre-formazione completamente auto-supervisionata) di circa il 2% per le prestazioni di classificazione degli eventi rispetto ai modelli con calcolo comparabile e, ancora più impressionante, ha tenuto il passo o superato i modelli con risorse di calcolo di livello industriale. Il modello del team si è classificato in modo simile ai modelli addestrati solo sulla perdita contrastiva. E sorprendentemente, afferma il team, l’incorporazione di dati multi-modali nella pre-formazione CAV-MAE migliora notevolmente la messa a punto della rappresentazione della singola modalità tramite l’apprendimento supervisionato (con alcuni dati etichettati) e le prestazioni nei compiti di classificazione degli eventi solo audio. Ciò dimostra che, come gli esseri umani, le informazioni multi-modali forniscono un ulteriore impulso “etichetta morbida” anche per i compiti solo audio o visivi; ad esempio, aiuta il modello a capire se sta cercando una chitarra elettrica o acustica – un segnale di supervisione più ricco.

“Penso che alle persone piaccia l’eleganza di questo modello per la combinazione di informazioni nei diversi flussi audio e visivi. Ha la perdita contrastiva e la perdita di ricostruzione, e rispetto ai modelli che sono stati valutati con dati simili, fa chiaramente molto bene su una serie di questi compiti”, dice Glass.

Per fare un passo avanti, “una cosa speciale è che il nostro modello può fare sia la classificazione che il recupero, il che non è comune”, aggiunge Gong. “Prima di questo lavoro, questi metodi venivano utilizzati separatamente, ma dopo questo lavoro vedo che la maggior parte dei framework di apprendimento audio-visivo utilizza la perdita di contrasto e l’autoencoder mascherato insieme, implicitamente o esplicitamente”.

Portare l’apprendimento audio-visivo auto-supervisionato nel nostro mondo

I ricercatori vedono il loro contributo all’autoencoder mascherato audio-visivo contrastivo (CAV-MAE) come una pietra miliare importante e un passo avanti per le applicazioni, che si stanno sempre più spostando dalla singola modalità alla multi-modalità e che richiedono o sfruttano la fusione audio-visiva. Ipotizzano che un giorno potrebbe essere utilizzato per il riconoscimento delle azioni in ambiti come lo sport, l’istruzione, l’intrattenimento, i veicoli a motore e la sicurezza pubblica. Potrebbe anche, un giorno, estendersi ad altre modalità. Al momento, il fatto che “questo si applica solo ai dati audio-visivi potrebbe essere un limite, ma stiamo puntando all’apprendimento multi-modale, che è una tendenza dell’apprendimento automatico”, dice Gong. “Come esseri umani, abbiamo multi-modalità – abbiamo l’olfatto, il tatto – molte cose in più rispetto al solo audio-visivo. Quindi, quando cerchiamo di costruire l’AI, cerchiamo di imitare gli esseri umani in qualche modo, non necessariamente dal punto di vista biologico, e questo metodo potrebbe [potenzialmente] essere generalizzato ad altre modalità inesplorate”.

Come i modelli di apprendimento automatico continuano a svolgere un ruolo sempre più importante nelle nostre vite, tecniche come questa diventeranno sempre più preziose.

Questa ricerca è stata supportata dal MIT-IBM Watson AI Lab.