OpenAI apre le porte all’IA aziendale

OpenAI apre all'IA aziendale

Perché ChatGPT sarà presto il tuo miglior collega pagato

Benvenuti nel futuro delle soluzioni aziendali: uno spazio che sta venendo conquistato dall’Intelligenza Artificiale (IA), e più precisamente dal nuovo focus B2B di OpenAI.

Con l’esplosione di strumenti e tecnologie, le aziende stanno sfruttando un’onda di innovazione come mai prima d’ora. Ma mentre le offerte proliferano e gli aggiornamenti si susseguono a ritmo frenetico, può essere una sfida sconcertante navigare in questo panorama e decidere cosa è giusto per la tua azienda.

Ecco dove entra in gioco questa introduzione. Per essere la tua bussola nella giungla dell’IA, guidandoti attraverso i due cambiamenti più importanti avvenuti quest’estate e che stanno costringendo l’industria a reinventare il modo in cui pensiamo all’IA SaaS sul posto di lavoro.

- Fine-Tuning per ChatGPT – Crea un modello con cui puoi chattare e che sa tutto ciò su cui desideri addestrarlo.

- Enterprise ChatGPT – Implementazioni aziendali private di ChatGPT con tutte le funzionalità offerte agli utenti Plus e altro ancora!

Continua a leggere per comprendere queste aggiornamenti sismici per ciò che sono e per ciò che non sono.

- Evolution nel tuo codice comprensione e codifica dell’algoritmo genetico da zero – Parte 1

- Pandas Playbook 7 Funzioni di dati complete da conoscere

- Una guida semplice di Hugging Face per chattare con il modello Llama-2 7B in un notebook Colab

Non si tratta solo di restare aggiornati con le ultime tendenze; si tratta di sfruttare l’apice di ciò che l’IA ha da offrire in questo momento. E fidati, non vuoi perderti questa opportunità. Gli ultimi aggiornamenti non lasciano scuse per qualsiasi azienda che aspettava di salire su questo treno. Anche i più scettici saranno in grado di capire perché la combinazione di privacy di livello enterprise e personalizzazione flessibile è destinata a portare finalmente OpenAI sulla strada dei ricavi positivi con un ottimo product-market fit.

La crescita degli strumenti AI personalizzabili per le aziende

Il gioco è cambiato quando OpenAI ha rilasciato Fine-Tuning per GPT-3.5 Turbo. Se pensavi che l’IA stesse già facendo impazzire il settore aziendale, ripensaci. Questa nuova capacità ha portato sul tavolo qualcosa che era possibile solo con modelli più piccoli e open-source: la personalizzazione. Ma cosa significa questo per la tua azienda e perché dovresti preoccupartene? Beh, perché la personalizzazione si è dimostrata il fattore determinante in termini di prestazioni e scalabilità quando si punta a un caso d’uso specifico.

GPT-3.5 Turbo e il Fine-Tuning

GPT-3.5 Turbo non è solo un altro modello di linguaggio pre-addestrato; è già preparato per seguire istruzioni (funzionando bene come agente di chat). Ma ora ha la capacità di essere sottoposto a un fine-tuning a un grado di specificità che le iterazioni precedenti non potevano raggiungere. Ciò ti consente essenzialmente di rendere il modello “tuo”, insegnandogli le sfumature del tuo settore, le peculiarità della voce del tuo brand o addirittura le strategie specifiche di risoluzione dei problemi di cui hai bisogno.

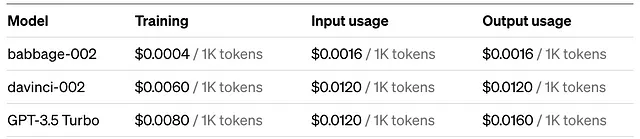

Le recenti pubblicazioni di OpenAI mostrano che un fine-tuning di GPT-3.5 può produrre risultati migliori rispetto a GPT-4 per il caso d’uso progettato. Inoltre, il costo per token dell’interazione con il 3.5 sottoposto a fine-tuning è inferiore del 60-80% rispetto alle chiamate GPT-4 (finestra di contesto di 8k).

È interessante notare che il costo di input/output è diverso, il che rende ancora più interessante utilizzare il GPT-3.5 sottoposto a fine-tuning per casi d’uso in cui si prevede un basso input e un’ampia produzione di output.

Che cos’è il Fine-Tuning?

Ok, sei entusiasta dei superpoteri personalizzabili che il fine-tuning porta a GPT-3.5 Turbo. Ma facciamo un passo indietro e approfondiamo cosa sia effettivamente il fine-tuning. Perché, diciamocelo, “fine-tuning” suona bene ma potrebbe sembrare un po’ tecnico per alcuni.

L’Essenza del Fine-Tuning

Immagina di avere una macchina sportiva. È già velocissima appena uscita dalla catena di produzione. Ma ora hai deciso che vuoi che sia la migliore su una pista specifica. Non sostituisci l’intero motore; invece, regoli la meccanica esistente – magari modifichi i rapporti del cambio, o forse investi in una migliore aerodinamica. Stai facendo il fine-tuning.

In modo simile, il fine-tuning prende un modello di intelligenza artificiale già addestrato e lo personalizza per compiti o ambiti specifici. Non stai costruendo un nuovo modello da zero; stai solo dando al modello esistente un “restyling” “minore” per migliorare le sue prestazioni nel settore desiderato.

Passaggi nel Fine-Tuning

- Preparazione dei Dati: Raccogli dati specifici del dominio.

- Preelaborazione: Pulisci e formatta questi dati per renderli compatibili.

- Addestramento: Il vero fine-tuning – addestra il modello sui tuoi dati personalizzati.

- Valutazione: Valuta le prestazioni del modello nel dominio specifico.

- Implementazione: Integra il modello nella tua applicazione.

Allora, Perché è Importante?

Ok, sembra interessante, ma dovresti preoccuparti? Sì!, Ecco perché:

Riduzione dei Costi API

Quando fai il fine-tuning di un modello, diventa più efficiente nel generare risultati rilevanti. Ciò significa meno chiamate API e, di conseguenza, costi più bassi. Le aziende hanno riportato una diminuzione dei costi API fino al 40% dopo aver fatto il fine-tuning dei loro modelli. Questo può essere ancora maggiore se suddividi il tuo caso d’uso per utilizzare il modello meno “intelligente” (più economico) per ogni passaggio che comunque raggiunge i tuoi obiettivi.

Aumento delle Prestazioni

Un modello generico cerca di essere un “uomo di tutti i mestieri”. Ma un modello sottoposto a fine-tuning diventa un maestro in uno – nel tuo dominio specifico. Il risultato? Maggiore precisione e meno necessità di intervento umano.

Soluzioni Differenziate

Un modello sottoposto a fine-tuning con la tua selezione di dati si comporterà in modo diverso da qualsiasi altra versione disponibile. Ciò consente alle aziende di creare veramente output unici, aprendo la porta a quelle startup che sviluppano soluzioni LLM per distinguersi e rendere la propria soluzione meno facilmente replicabile.

La Prevalenza dell’Ingegneria delle Richieste

Anche se il fine-tuning è come trasformare la tua macchina sportiva in un campione di pista, ci sono miglioramenti delle prestazioni che puoi ottenere senza recarti in officina per una revisione completa. Questo è, naturalmente, la nostra ben nota disciplina dell’Ingegneria delle Richieste – il frutto più abbondante nel giardino dell’ottimizzazione dell’IA.

Il Fine-Tuning Non è Sempre il Primo Passo

Non fraintendermi; il fine-tuning è uno strumento potente. Tuttavia, richiede risorse, come potenza di calcolo e dati specifici del dominio. Quindi, prima di immergerti nella personalizzazione, chiediti: “Posso ottenere risultati sufficientemente buoni senza modificare il modello di base?”

Ingegneria delle Richieste: La Tua Vittoria Veloce

Se sei nuovo al termine, l’ingegneria delle richieste è essenzialmente l’arte di formulare query o istruzioni in modo che guidino il modello di intelligenza artificiale a generare output desiderati. Nessun aggiustamento del modello, nessun costo aggiuntivo. Piccole modifiche al testo possono portare a risultati molto diversi e altamente mirati.

Ecco un esempio di base:

- Query Generica: “Parlami del caffè.”

- Richiesta Progettata: “Riassumi la storia, i benefici per la salute e i metodi di preparazione del caffè.”

Il secondo prompt è progettato per ottenere una risposta più strutturata e completa, consentendoti di massimizzare l’utilità del modello di base.

Tecniche avanzate: Prompt Chaining e Function Calling

Alziamo il livello. Il prompt chaining consiste nel suddividere un compito complesso in query più piccole e digeribili e alimentare l’output di una come input di un’altra. Ad esempio, chiedere al modello di riassumere prima un documento e quindi tradurre quel riassunto in un’altra lingua.

La function calling è un’innovazione più recente che consente l’uso di funzioni predefinite all’interno di una sessione di chat per completare compiti specifici. È come dare al tuo modello un insieme di utility da utilizzare, semplificando ulteriormente processi come l’estrazione dei dati o la sintesi del testo.

Perché dare priorità all’ingegneria dei prompt?

Tre motivi:

- Velocità: Risultati in tempo reale, nessuna attesa per l’addestramento del modello.

- Economicità: Nessun costo extra, particolarmente utile se stai ancora sperimentando le capacità dell’intelligenza artificiale.

- Flessibilità: Facile da regolare e perfezionare, consentendo iterazioni agili per adattarsi alle tue esigenze in evoluzione.

Prima di investire in un modello ottimizzato, testa le acque con l’ingegneria dei prompt. A volte, la differenza tra una buona soluzione e la migliore soluzione è semplicemente una domanda ben progettata.

Controllo e Conformità: Enterprise Edition

La pietra angolare di un’implementazione di intelligenza artificiale aziendale: sicurezza e conformità. Diciamocelo chiaramente; tutte le funzionalità di una soluzione tecnologica non significano nulla se non riesce a soddisfare gli rigorosi standard di sicurezza richiesti dalla tua organizzazione. Qui entra in gioco l’offerta Enterprise di OpenAI, annunciata il 28 agosto.

Anche se l’annuncio è stato fatto solo questa settimana, OpenAI dimostra che una lunga lista di clienti molto rispettabili ha già utilizzato la loro offerta Enterprise senza che fosse ancora pubblica.

I dettagli sono ancora scarsi e l’implementazione odierna richiede un’interazione dedicata con i team di vendita di OpenAI. Tuttavia, la soluzione promette di soddisfare le quattro C che il settore sta cercando: Controllo, Conformità, Personalizzazione e Collaborazione.

Controllo: Admin Console

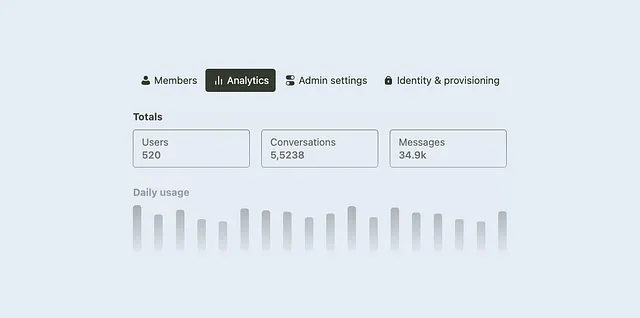

La versione Enterprise verrà fornita con una intuitiva Admin Console. Questo è il tuo centro di controllo, che fornisce una dashboard per gestire le chiavi API, monitorare l’utilizzo e impostare le autorizzazioni a livello dettagliato. È dove la governance incontra l’agilità: dallo stabilire le quote all’assegnazione dei ruoli, la console ti mette al volante.

Conformità: Sicurezza di livello enterprise

Questo è il fondamento su cui è costruita l’edizione enterprise. Prevedi una crittografia all’avanguardia sia a riposo che in transito. Vengono rispettati gli standard di conformità come il GDPR e SOC 2 (nessuna notizia su HIPAA, che Anthropic fornisce), garantendo che tu non violi gli obblighi legali.

Personalizzazione: Conservazione su misura e Ottimizzazione

Oltre alle capacità di ottimizzazione di cui abbiamo discusso, OpenAI garantisce che avrai il controllo su come vengono gestiti i dati. La versione enterprise offre opzioni per impostare politiche di conservazione dei dati personalizzate, garantendo che tu possa rispettare le normative o le linee guida interne su quanto tempo conservare i tuoi dati.

Inoltre, anche se non sono stato in grado di convalidare questo, la comunicazione aziendale afferma che l’aggiunta di conoscenze aziendali avrà un’interfaccia facile da usare per aggiungere fonti di dati per il modello che possono avere effetto per l’intera azienda.

Collaborazione: Modelli di chat condivisibili

Lavorare in un silos è stato un problema fin dall’inizio di ChatGPT. Prima con conversazioni condivisibili e ora con modelli, OpenAI riconosce che lo spazio di lavoro moderno ruota attorno alla collaborazione. Con i modelli di chat, i team saranno in grado di distribuire, testare e migliorare i design delle conversazioni senza correre il rischio di accessi o modifiche non autorizzate. E sì, questi sono link sicuri che si attengono alle migliori pratiche in materia di privacy e protezione.

Casi d’uso specifici che stanno raccogliendo i frutti

Il fine-tuning si distingue in diversi settori e il suo potenziale è immenso:

- Servizio Clienti: Dimenticate le risposte preconfezionate. Le aziende stanno ora ottimizzando GPT-3.5 Turbo per comprendere a fondo i loro prodotti, offrendo supporto clienti automatizzato e sorprendentemente abile.

- Scrittura di contenuti: Qualcosa che i nostri clienti ci hanno spesso chiesto è come assicurarsi che i contenuti scritti dall’IA rispettino lo stile e le linee guida del loro brand. Di solito ciò viene ottenuto attraverso il red-teaming, ma non è molto accurato. Con questi cambiamenti, il vostro brand può avere un messaggio chiaro che sarà rispettato in tutti i contenuti generati.

- Output formattati: Le attuali applicazioni basate su LLM comunemente cercano di estrarre JSON, Markdown o altri formati specifici dalle risposte. Ciò comporta spesso dei rischi, in quanto il modello potrebbe non rispondere sempre nel formato perfetto. Per questo motivo, i programmatori hanno dovuto creare flussi di test e ripetizioni. Ora potete educare il vostro modello a seguire meglio le vostre esigenze di formattazione.

- Settore legale: I modelli ottimizzati per i documenti che la vostra azienda ha già elaborato possono filtrare il gergo legale per produrre riassunti o addirittura bozze di documenti legali che corrispondano agli argomenti legali trattati e utilizzino le ultime giurisprudenze. Se non volete finire sui giornali citando casi immaginari, questa è la strada da percorrere.

- Sanità e Ricerca: Modelli personalizzati assistono nelle diagnosi mediche, offrendo suggerimenti preliminari basati su anni di riviste e studi.

Adottatori precoci e i loro successi

Dai giganti globali alle start-up vivaci, molti si sono lanciati sulla strada dell’ottimizzazione e stanno raccogliendo benefici tangibili. Un caso notevole è Salesforce, che ha integrato GPT-3.5 Turbo ottimizzato nel suo software di gestione delle relazioni con i clienti (CRM). Il risultato? Una riduzione del 35% del tempo medio di gestione delle richieste di supporto clienti.

Una nota sull’orizzonte

Mentre abbiamo coperto la moltitudine di capacità promesse dalla nuova edizione Enterprise di OpenAI, vale la pena menzionare che i dettagli completi sono ancora dietro al velo dell’impegno commerciale di OpenAI. Di conseguenza, tenete d’occhio questo spazio: questo articolo potrebbe subire aggiornamenti per riflettere nuove intuizioni man mano che emergono.

Inoltre, poiché il panorama aziendale inizia a sperimentare più intensamente le opzioni di ottimizzazione, aspettatevi ulteriori articoli che approfondiscano casi d’uso emergenti, metriche di performance e migliori pratiche. In un dominio in rapida evoluzione, rimanere informati non è solo vantaggioso, ma essenziale per ottenere un vantaggio competitivo.

Fonti

- OpenAI Developer Guide: Fine-Tuning

- OpenAI Blog: ChatGPT Enterprise

- OpenAI Blog: Function Calling and Other API Updates

- OpenAI Pricing: API Cost by 1k Tokens

- Deeplearning.ai — Fine-Tuning Large Language Models

- Come Salesforce Research Utilizza l’IA Generativa come una Forza per il Bene