Microsoft AI presenta Orca un modello di 13 miliardi di parametri che impara a imitare il processo di ragionamento dei LFM (Large Foundation Models).

Microsoft AI presenta Orca, un modello di 13 miliardi di parametri che imita il processo di ragionamento dei LFM.

Le notevoli capacità di apprendimento zero-shot dimostrate dai modelli di base di grandi dimensioni (LFM) come ChatGPT e GPT-4 hanno suscitato una domanda: questi modelli possono supervisionare autonomamente il loro comportamento o altri modelli con minima intervento umano? Per esplorare questo, un team di ricercatori di Microsoft presenta Orca, un modello di 13 miliardi di parametri che apprende tracce di spiegazioni complesse e processi di pensiero passo dopo passo da GPT-4. Questo approccio innovativo migliora significativamente le prestazioni dei modelli di istruzioni a stato dell’arte esistenti, affrontando sfide legate alla diversità delle attività, alla complessità delle query e alla scalabilità dei dati.

I ricercatori riconoscono che le coppie di query e risposta di GPT-4 possono fornire una guida preziosa per i modelli degli studenti. Pertanto, migliorano queste coppie aggiungendo risposte dettagliate che offrono una migliore comprensione del processo di ragionamento impiegato dagli insegnanti quando generano le loro risposte. Incorporando queste tracce di spiegazioni, Orca equipaggia i modelli degli studenti con abilità di ragionamento e comprensione migliorate, colmando efficacemente il divario tra insegnanti e studenti.

Il team di ricerca utilizza la raccolta Flan 2022 per migliorare ulteriormente il processo di apprendimento di Orca. Il team campiona attività da questa vasta collezione per garantire un mix diversificato di sfide. Questi compiti vengono quindi sottocampionati per generare prompt complessi, che fungono da query per LFMs. Questo approccio crea un set di allenamento diversificato e ricco che facilita l’apprendimento robusto per Orca, consentendogli di affrontare efficacemente una vasta gamma di attività.

- Come ho eseguito l’etichettatura automatica delle immagini utilizzando il grounding DINO.

- Corso gratuito di ChatGPT utilizza l’API di OpenAI per creare 5 progetti.

- Cosa sono i modelli di base e come funzionano?

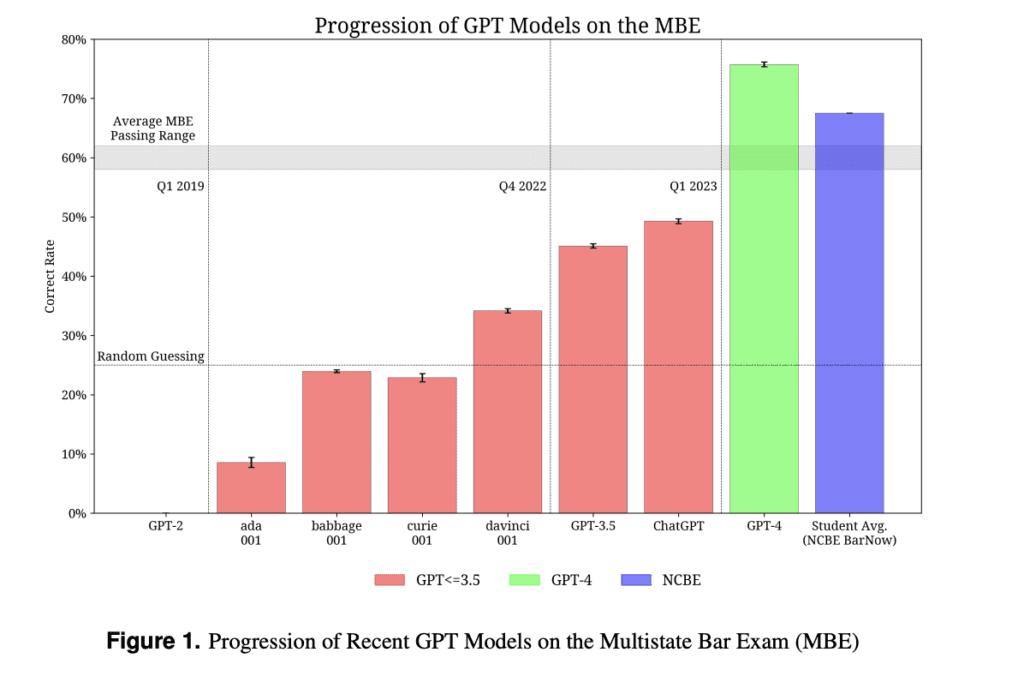

I ricercatori conducono valutazioni esaustive per valutare le capacità di Orca, concentrandosi sulle capacità di generazione, ragionamento e comprensione. Confrontano le prestazioni di Orca con basi solide come Text-Davinci-003, ChatGPT, GPT-4 e Vicuna. I risultati dimostrano la superiorità di Orca rispetto ai modelli di istruzioni a stato dell’arte come Vicuna-13B, mostrando un miglioramento di oltre il 100% su BigBench Hard (BBH). Inoltre, Orca presenta prestazioni competitive nei test accademici in ambienti zero-shot, indicando il suo potenziale per le applicazioni del mondo reale.

I risultati della ricerca confermano il tremendo potenziale dell’apprendimento da spiegazioni passo-passo nell’incrementare le prestazioni del modello. Incorporando tracce di spiegazioni dettagliate e scalando le attività con prompt complessi, Orca ottiene significativi progressi nei modelli di istruzioni. Questo approccio non solo consente ai modelli degli studenti di migliorare le loro abilità di ragionamento e comprensione, ma anche di superare i benchmark esistenti.

L’introduzione di Orca e la sua applicazione di successo nel migliorare i modelli di istruzioni presentano prospettive entusiasmanti per la ricerca futura. Poiché gli LFM continuano a evolversi, i meccanismi di apprendimento auto-supervisionato e la capacità di supervisionare altri modelli con minimo intervento umano potrebbero rivoluzionare il campo dell’intelligenza artificiale. Raffinando il processo di apprendimento dalle tracce di spiegazioni complesse, i ricercatori possono continuare a migliorare le prestazioni del modello su varie attività, guidando gli avanzamenti nel processing del linguaggio naturale.

In conclusione, l’introduzione di Orca, un modello di 13 miliardi di parametri che apprende tracce di spiegazioni da GPT-4, rappresenta una significativa svolta nell’avanzamento dei modelli di istruzioni. Orca supera i modelli esistenti attraverso l’ottimizzazione delle spiegazioni, la scalabilità delle attività e le valutazioni rigorose, segnando un sostanziale salto in avanti nelle capacità dei sistemi di intelligenza artificiale. L’incorporazione di spiegazioni passo-passo nei processi di formazione promette di sbloccare completamente il potenziale dei grandi modelli di base e guidare il progresso nel processing del linguaggio naturale.