Meta AI presenta MusicGen un modello di generazione musicale semplice e controllabile attivato sia dal testo che dalla melodia.

Meta AI introduces MusicGen, a simple and controllable music generation model activated by both text and melody.

Creare composizioni musicali da descrizioni di testo, come “canzone rock degli anni ’90 con un riff di chitarra”, è la conversione testo-musica. Poiché coinvolge la simulazione di processi a lungo raggio, creare musica è un compito difficile. La musica, a differenza del parlato, richiede l’utilizzo di tutto il range di frequenza. Ciò comporta un campionamento del segnale più frequente; ad esempio, le registrazioni musicali utilizzano di solito frequenze di campionamento di 44,1 kHz o 48 kHz invece di 16 kHz per il parlato. Inoltre, le armonie e le melodie di diversi strumenti si combinano per formare strutture complesse nella musica. Gli ascoltatori umani sono estremamente sensibili alla discordanza. Pertanto, c’è poco margine di errore melodico nella creazione di musica.

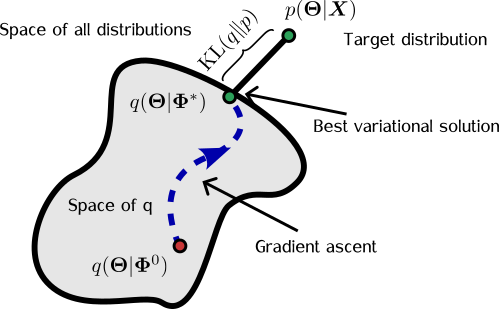

Ultimo ma non meno importante, è fondamentale per i produttori di musica avere il potere di regolare il processo di generazione utilizzando vari strumenti, tra cui tasti, strumenti, melodia, genere, ecc. I recenti sviluppi nella sintesi audio, nella modellizzazione sequenziale e nell’apprendimento rappresentazionale audio auto-supervisionato rendono possibile il quadro per la creazione di tali modelli. La recente ricerca suggerisce di esprimere i segnali audio come diversi flussi di token discreti che rappresentano lo stesso segnale per rendere la modellizzazione audio più gestibile. Ciò consente sia una modellizzazione audio efficiente che una generazione audio di alta qualità. Ciò comporta tuttavia la modellizzazione congiunta di diversi flussi paralleli dipendenti.

I ricercatori hanno suggerito di modellare diversi flussi di token di discorso contemporanei utilizzando un metodo di ritardo o aggiungendo offset tra i vari flussi. Altri hanno suggerito di modellare le parti musicali utilizzando una gerarchia di modelli autoregressivi e di mostrarle utilizzando diverse sequenze di token discreti a granularità variabile. Parallelamente a ciò, diversi ricercatori utilizzano una strategia simile per generare il canto con accompagnamento. I ricercatori di Meta AI presentano MUSICGEN in questo studio, un modello di generazione musicale semplice e controllato che può produrre musica di alta qualità da una descrizione scritta.

- Dalla GPT-3 alle Future Generations dei modelli linguistici

- Questa ricerca sull’Intelligenza Artificiale propone un metodo di sintesi vocale personalizzato Zero-Shot Lip2Speech un modello di sintesi vocale sintetico per abbinare i movimenti delle labbra.

- Immaginando il futuro dell’informatica

Come generalizzazione della ricerca precedente, essi forniscono un quadro generico per modellare numerosi flussi contemporanei di token acustici. Inoltre, incorporano il condizionamento melodico non supervisionato, che consente al modello di produrre musica che si adatta a una specifica struttura armonica e melodica per aumentare la controllabilità dei campioni creati. Hanno studiato attentamente MUSICGEN e dimostrato che è molto migliore rispetto alle basi analizzate, assegnandogli un punteggio soggettivo di 84,8 su 100 rispetto all’80,5 della migliore base. Offrono anche una ricerca di ablazione che chiarisce l’importanza di ciascun componente sulle prestazioni dell’intero modello.

Infine, l’analisi umana indica che MUSICGEN produce campioni di alta qualità che sono più melodicamente allineati con una specifica struttura armonica e rispettano una descrizione scritta. Il loro coinvolgimento: (i) presentano una metodologia semplice ed efficace per produrre musica di alta qualità a 32 kHz. Dimostrano come MUSICGEN possa creare musica affidabile utilizzando un modello di linguaggio a singolo stadio e una tecnica di intrecciamento di codebook di successo. (ii) Forniscono un singolo modello per effettuare sia la generazione condizionata al testo che la generazione condizionata alla melodia, e mostrano che l’audio generato è fedele alle informazioni di condizionamento del testo e coerente con la melodia data. (iii) Offrono valutazioni approfondite delle decisioni di progettazione fondamentali del loro metodo che sono sia oggettive che soggettive. L’implementazione PyTorch del codice per MusicGen è disponibile nella libreria AudioCraft su GitHub.