Il Potere della Distanza della Conoscenza nell’IA Moderna Colmare il Divario tra Modelli Potenti e Compatti

Il Potere della Distanza della Conoscenza nell'IA Moderna

Nel paesaggio in continua evoluzione dell’intelligenza artificiale, con modelli che aumentano in complessità e dimensione, sorge la sfida: come possiamo distribuire questi modelli colossali su hardware con risorse limitate? Entra nel campo della Distillazione della Conoscenza – una tecnica che promette di rivoluzionare le implementazioni di IA, specialmente in ambienti con risorse limitate.

Cosa è la Distillazione della Conoscenza?

Alla base, la distillazione della conoscenza consiste nel trasferire la conoscenza da un modello grande e complesso (spesso chiamato insegnante) a un modello più piccolo e semplice (lo studente). Invece di addestrare il modello studente direttamente sui dati grezzi, viene addestrato utilizzando le uscite del modello insegnante. Lo studente impara essenzialmente dall’esperienza dell’insegnante, catturando l’essenza della sua conoscenza senza ereditarne la complessità.

Perché la Distillazione della Conoscenza è Cruciale nell’IA Moderna

In questa era in rapida evoluzione dell’intelligenza artificiale, c’è una continua spinta e trazione tra la necessità di modelli più potenti e i vincoli pratici della distribuzione. Mentre il deep learning ci ha fornito modelli con una precisione e capacità senza precedenti, ha anche introdotto sfide legate alle loro dimensioni e alle richieste computazionali. È qui che la distillazione della conoscenza emerge come un elemento rivoluzionario.

Non si tratta solo di rendere i modelli più piccoli; si tratta di preservare l’essenza delle capacità di un grande modello in una forma più compatta. Ecco alcune ragioni che sottolineano l’importanza della distillazione della conoscenza nell’ecosistema dell’IA odierna.

- Analisi dei sentimenti sulle recensioni degli hotel su TripAdvisor con ChatGPT

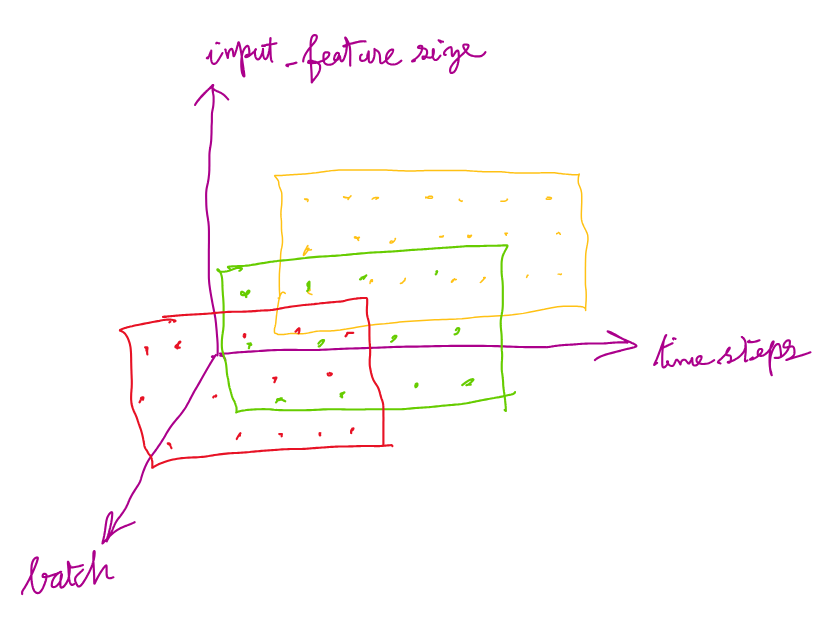

- PyTorch LSTMCell – Forme di Input, Stato Nascosto, Stato della Cella e Output

- Estrazione di sinonimi (parole simili) dal testo utilizzando BERT & NMSLIB 🔥

- Dilemma Dimensione Modello vs. Prestazioni: Man mano che i modelli di deep learning diventano più complessi, offrono migliori prestazioni ma a costo di dimensioni e richieste computazionali maggiori. La distillazione della conoscenza fornisce un ponte, permettendoci di mantenere un alto livello di prestazioni riducendo l’impronta del modello.

- IA su Dispositivi Edge: Con la crescita di IoT e del calcolo edge, c’è una crescente domanda di esecuzione di modelli di IA su dispositivi con potenza computazionale limitata. La distillazione della conoscenza facilita ciò creando modelli compatti che possono operare in modo efficiente su tali dispositivi senza…