Bootcamp LLM Full Stack gratuito

'Free LLM Full Stack Bootcamp'

Vuoi saperne di più sugli LLM e costruire fantastiche applicazioni con LLM? Questo Bootcamp gratuito Full Stack LLM è tutto ciò di cui hai bisogno!

I Large Language Models (LLM) e le applicazioni LLM sono l’argomento del momento! Che tu sia interessato ad esplorarli per progetti personali, ad usarli al lavoro per massimizzare la produttività o per riassumere velocemente i risultati di ricerca e le pubblicazioni scientifiche, gli LLM offrono qualcosa per tutti, in tutto lo spettro.

Questo è fantastico! Ma se vuoi migliorare nell’uso degli LLM e andare oltre l’utilizzo di queste applicazioni e iniziare a costruire le tue, il gratuito LLM Bootcamp del team Full Stack è la soluzione ideale.

- Allenare il tuo primo agente RL basato su Deep Q Learning Una guida passo-passo

- Costruisci modelli di ML ad alte prestazioni utilizzando PyTorch 2.0 su AWS – Parte 1.

- Annuncio estrazioni di tabelle migliorate con Amazon Textract

Dall’ingegneria dei prompt per l’utilizzo efficace degli LLM, alla costruzione delle tue applicazioni e alla progettazione di interfacce utente ottimali per le app LLM, questo bootcamp copre tutto. Scopriamo di più su ciò che il bootcamp offre.

Cos’è il Full Stack LLM Bootcamp?

Il Full Stack LLM Bootcamp è stato originariamente tenuto come evento in presenza a San Francisco nell’aprile del 2023. E ora, i materiali del bootcamp – lezioni, diapositive, codice sorgente per i progetti – sono tutti accessibili gratuitamente.

Il bootcamp LLM mira a fornire un approccio completo. Copre tecniche di ingegneria dei prompt, fondamentali degli LLM, fino alla costruzione e all’invio di app LLM in produzione.

Questo bootcamp è tenuto dagli istruttori: Charles Frye, Josh Torbin e Sergey Karayev, tutti ex allievi di UC Berkeley. E il loro obiettivo è far sì che tutti siano al passo con gli ultimi progressi degli LLM:

“Il nostro obiettivo è farvi raggiungere il 100% dello stato dell’arte e prepararvi a costruire e distribuire app LLM, indipendentemente dal vostro livello di esperienza con l’apprendimento automatico.” – Il team Full Stack

Un’occhiata ravvicinata al Full Stack LLM Bootcamp

Ora che sappiamo di cosa si tratta il bootcamp LLM, approfondiamo il contenuto del corso.

Prerequisiti

Sebbene non ci siano prerequisiti obbligatori, tranne un interesse genuino nell’apprendimento degli LLM, qualche esperienza di programmazione pertinente può semplificare il tuo percorso. Ecco alcuni di questi prerequisiti:

- Esperienza con la programmazione in Python

- Familiarità con l’apprendimento automatico, lo sviluppo front-end o back-end sarà utile

Imparare a scrivere: Ingegneria dei prompt

Perché i modelli linguistici producano risultati desiderabili, è importante migliorare la scrittura dei prompt.

Il modulo Imparare a scrivere: Ingegneria dei prompt copre quanto segue:

- Pensare in modo probabilistico agli output degli LLM

- I concetti di base della scrittura dei prompt nei modelli preaddestrati come GPT-3 e LLaMa, nei modelli addestrati con le istruzioni come ChatGPT e negli agenti che imitano le persone

- Tecniche di ingegneria dei prompt e le migliori pratiche come la decomposizione, la combinazione degli output di diversi LLM, l’uso della casualità e altro ancora

LLMOps

Anche solo per le applicazioni di apprendimento automatico semplici, la costruzione del modello è solo la punta dell’iceberg. La vera sfida sta nel distribuire il modello in produzione e monitorare e mantenere le sue prestazioni nel tempo.

Il modulo LLMOps del bootcamp copre:

- Scegliere il miglior LLM per la tua applicazione considerando la velocità, il costo, la personalizzabilità e la disponibilità di licenze open-source e restrittive

- Migliorare la gestione dei prompt integrando il tracciamento dei prompt nel flusso di lavoro (usando Git o altri sistemi di controllo versione)

- Testare gli LLM

- Le sfide dell’implementazione dello sviluppo guidato dai test (TDD) nelle app LLM

- Metriche di valutazione per LLM

- Monitorare le metriche delle prestazioni, raccogliere i feedback degli utenti e apportare le modifiche necessarie

UX per le interfacce utente per il linguaggio

Oltre a considerare l’infrastruttura e concentrarsi sulla scelta del modello, il successo dell’applicazione dipende dall’esperienza utente.

Il modulo su UX per le interfacce utente per il linguaggio copre:

- Principi di progettazione per la progettazione centrata sull’uomo e empatica di quella e delle interfacce di prodotto

- Tenere conto di fattori di convenienza come l’autocompletamento, la bassa latenza e altro ancora

- Casi studio per approfondire ciò che funziona (e ciò che non funziona)

- Importanza della ricerca UX

Modelli di linguaggio aumentati

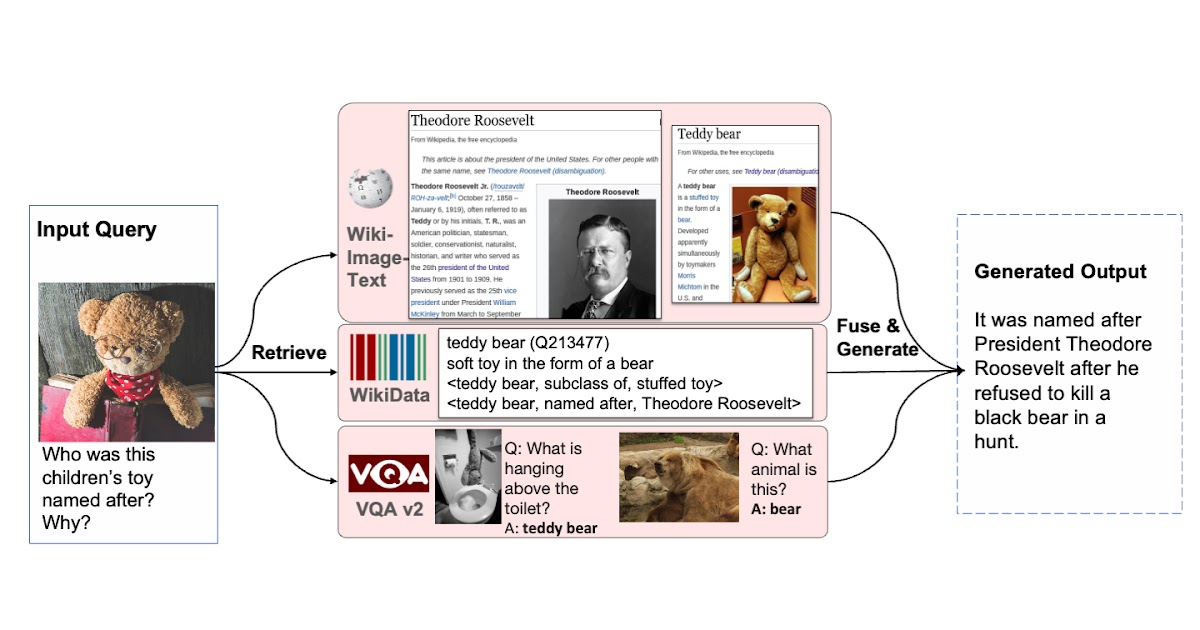

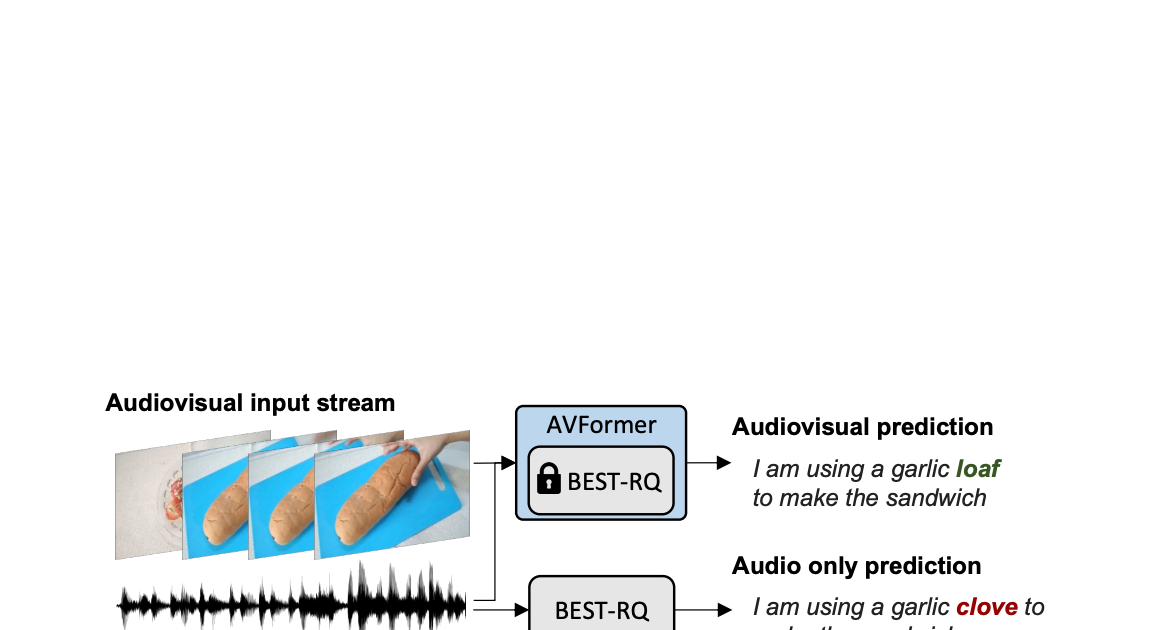

I modelli di linguaggio aumentati sono al centro di tutte le applicazioni basate su LLM. Spesso, avremmo bisogno che i modelli di linguaggio abbiano capacità di ragionamento migliori, lavorino con set di dati personalizzati e utilizzino informazioni aggiornate per rispondere alle query.

Il modulo sui modelli di linguaggio aumentati copre i concetti:

- Recupero delle informazioni alimentato dall’AI

- Tutto sugli embedding

- Concatenazione di chiamate LLM a più modelli di linguaggio

- Utilizzo efficace di strumenti come LangChain

Lanciare un’app LLM in un’ora

Questo modulo ti insegna come costruire rapidamente app LLM, compresi:

- Procedere con i processi di prototipazione, iterazione e distribuzione per costruire un’app MVP

- Utilizzare diverse pile tecnologiche per costruire un prodotto utile: dai modelli di linguaggio di OpenAI fino al sfruttamento dell’infrastruttura serverless

Fondamenti di LLM

Se sei interessato a capire i fondamenti dei grandi modelli di linguaggio insieme alle innovazioni degli anni, il modulo sui fondamenti di LLM ti aiuterà a capire quanto segue:

- Fondamenti del machine learning

- Transformers e attenzioni

- LLM importanti come la famiglia di LLM GPT-3 e gli elementi di svolta LLaMA importanti

Progetto Passo-Passo: askFSDL

Il bootcamp ha anche una sezione dedicata che ti guida attraverso il progetto askFSDL, un’app alimentata da LLM che è costruita sul corpus del corso di Full Stack Deep Learning.

Il corso Full Stack Deep Learning del team è un’altra eccellente risorsa per imparare le migliori pratiche per costruire e distribuire modelli di deep learning in produzione.

Dalla raccolta e pulizia dei dati, ai passaggi di elaborazione ETL e dati, fino alla costruzione di front-end e back-end, distribuzione e configurazione del monitoraggio del modello, questo è un progetto full stack che puoi provare a replicare e imparare molto lungo il percorso.

Ecco una panoramica (non esaustiva) di ciò che usa il progetto:

- LLM di OpenAI

- MongoDB per memorizzare il corpus dei documenti puliti

- Indice FAISS per una ricerca più veloce nel corpus

- LangChain per concatenare le chiamate LLM e la gestione delle prompt

- Ospitare il back-end dell’applicazione su Modal

- Monitoraggio del modello con Gantry

Conclusione

Spero che tu sia entusiasta di imparare di più sugli LLM lavorando attraverso il bootcamp LLM. Buono studio!

Puoi anche interagire con altri studenti e membri della comunità unendoti a questo server Discord. Ci sono talk invitati di esperti del settore (come OpenAI e Repl.it) e creatori di strumenti nello spazio LLM. Questi talk saranno anche caricati a breve sul sito del bootcamp.

Interessato a controllare altri corsi su LLM? Ecco una lista dei migliori corsi gratuiti su LLM. Bala Priya C è uno sviluppatore e scrittore tecnico dall’India. Le piace lavorare all’incrocio di matematica, programmazione, data science e creazione di contenuti. Le sue aree di interesse e competenza includono DevOps, data science e elaborazione del linguaggio naturale. Ama leggere, scrivere, codificare e il caffè! Attualmente sta lavorando per imparare e condividere la sua conoscenza con la comunità degli sviluppatori scrivendo tutorial, guide pratiche, articoli di opinione e altro ancora.