Esperti di Machine Learning – Lewis Tunstall

Esperti di Machine Learning - Lewis Tunstall

🤗 Benvenuti agli esperti di Machine Learning – Lewis Tunstall

Ciao amici! Benvenuti agli esperti di Machine Learning. Sono la vostra conduttrice, Britney Muller e l’ospite di oggi è Lewis Tunstall. Lewis è un Ingegnere di Machine Learning presso Hugging Face, dove lavora sull’applicazione dei Transformer per automatizzare i processi aziendali e risolvere le sfide di MLOps.

Lewis ha sviluppato applicazioni di ML per startup e aziende nei settori di NLP, analisi dei dati topologici e serie temporali.

Ascolterete Lewis parlare del suo nuovo libro, dei Transformer, dell’valutazione su larga scala dei modelli, di come sta aiutando gli ingegneri di ML ad ottimizzare per una latenza più veloce e un throughput più elevato, e altro ancora.

In una vita precedente, Lewis era un fisico teorico e al di fuori del lavoro ama suonare la chitarra, correre nei sentieri e contribuire a progetti open-source.

- Emissioni di CO2 e l’🤗 Hub Guidare l’Avanzata

- Servizio clienti potenziato con l’apprendimento automatico

- Presentazione di Hugging Face per l’Educazione 🤗

Sono molto entusiasta di presentarvi questo episodio divertente e brillante! Ecco la mia conversazione con Lewis Tunstall:

Nota: La trascrizione è stata leggermente modificata/riformattata per offrire la migliore esperienza di lettura.

Benvenuto, Lewis! Grazie mille per aver dedicato del tempo al mio chat oggi riguardo al tuo fantastico lavoro!

Lewis: Grazie, Britney. È un piacere essere qui.

Curioso se puoi fare una breve auto-presentazione e evidenziare cosa ti ha portato a Hugging Face?

Lewis: Quello che mi ha portato a Hugging Face sono i Transformer. Nel 2018, stavo lavorando con i Transformer in una startup in Svizzera. Il mio primo progetto era un compito di domande e risposte in cui si inserisce del testo e si addestra un modello per cercare di trovare la risposta a una domanda all’interno di quel testo.

In quei giorni la libreria si chiamava: pytorch-pretrained-bert, era un codice molto focalizzato con un paio di script ed è stata la prima volta che ho lavorato con i Transformer. Non avevo idea di cosa stesse succedendo, così ho letto il paper originale “Attention Is All You Need”, ma non riuscivo a capirlo. Così ho iniziato a cercare altre risorse per imparare.

Nel frattempo, Hugging Face è esploso con la loro libreria che si è ampliata con molte architetture e mi sono entusiasmato molto nel contribuire al software open-source. Così verso il 2019, ho avuto questa idea un po’ folle di scrivere un libro sui Transformer perché sentivo che c’era una lacuna di informazioni. Così mi sono associato al mio amico Leandro (von Werra) e abbiamo inviato a Thom (Wolf) una e-mail a sorpresa dicendo: “Ehi, stiamo per scrivere un libro sui Transformer, sei interessato?” e mi aspettavo di non ricevere risposta. Ma per nostra grande sorpresa, ha risposto “Sì, certo, facciamo una chiacchierata”. E circa un anno e mezzo dopo ecco il nostro libro: NLP con i Transformer.

Questa collaborazione ha gettato le basi per me e Leandro per unirci a Hugging Face. E sono qui da circa nove mesi.

È incredibile. Come ti senti nel tenere una copia del tuo libro tra le mani?

Lewis: Devo dire che sono diventato genitore circa un anno e mezzo fa e si sente un po’ simile alla nascita di mio figlio. Stai tenendo tra le mani qualcosa che hai creato.

È una sensazione molto emozionante e così diversa dal leggerlo in formato PDF. Conferma che è effettivamente reale e che non l’ho solo sognato.

Esattamente. Congratulazioni!

Vorresti leggere brevemente una recensione che amo molto su questo libro;

“_Complessità resa semplice. Questo è un libro raro e prezioso su NLP, Transformer e l’ecosistema in crescita intorno ad essi, Hugging Face. Che questi siano ancora parole di moda per te o che tu abbia già una solida comprensione di tutto, gli autori ti guideranno con umorismo, rigore scientifico e molti esempi di codice nei segreti più profondi della tecnologia più cool del momento. Dai modelli “pre-addestrati” a quelli “personalizzati”, e dalle prestazioni ai problemi di etichettatura mancante, gli autori affrontano praticamente tutte le difficoltà reali di un ingegnere di ML e forniscono soluzioni all’avanguardia, rendendo questo libro destinato a dettare gli standard nel campo per anni a venire._” – Luca Perrozi Ph.D., Data Science e Machine Learning Associate Manager presso Accenture.

Scopri l’Elaborazione del Linguaggio Naturale con i Transformers.

Puoi parlare del lavoro che hai svolto con la libreria transformers?

Lewis: Una delle cose che ho sperimentato nei miei precedenti lavori prima di Hugging Face è stata questa sfida nell’industria quando si tratta di distribuire questi modelli in produzione; questi modelli sono davvero grandi in termini di numero di parametri e questo aggiunge molta complessità ai requisiti che potresti avere.

Ad esempio, se stai cercando di costruire un chatbot hai bisogno che questo modello sia molto veloce e reattivo. E la maggior parte delle volte questi modelli sono un po’ troppo lenti se prendi solo un modello preconfezionato, lo addestri e poi cerchi di integrarlo nella tua applicazione.

Quindi, quello su cui ho lavorato negli ultimi mesi sulla libreria transformers è fornire la funzionalità di esportare questi modelli in un formato che ti consenta di eseguirli in modo molto più efficiente utilizzando gli strumenti che abbiamo su Hugging Face, ma anche solo gli strumenti generali nell’ecosistema open-source.

In un certo senso, la filosofia della libreria transformers è scrivere molto codice in modo che gli utenti non debbano scrivere quel codice.

In questo esempio specifico, stiamo parlando di qualcosa chiamato formato ONNX. È un formato speciale che viene utilizzato nell’industria in cui puoi essenzialmente avere un modello scritto in PyTorch, ma puoi poi convertirlo in TensorFlow o eseguirlo su hardware molto dedicato.

E se guardi effettivamente a cosa serve per realizzare questa conversione nella libreria transformers, è piuttosto complicato. Ma facciamo in modo che tu debba eseguire solo una riga di codice e la libreria si prenderà cura di te.

Quindi l’idea è che questa particolare funzionalità permette agli ingegneri di machine learning o persino agli scienziati dei dati di prendere il loro modello, convertirlo in questo formato e poi ottimizzarlo per ottenere una latenza più veloce e una maggiore velocità di elaborazione.

È molto interessante. Ci sono state applicazioni di transformers particolarmente sorprendenti?

Lewis: Ne penso che ci siano alcune. Una è forse emotiva o personale, ad esempio quando OpenAI ha rilasciato GPT-2, questo famoso modello di linguaggio in grado di generare testi.

OpenAI ha effettivamente fornito nei loro post del blog alcuni esempi degli articoli che questo modello aveva creato. E uno di essi era davvero divertente. Era un saggio sul perché non dovremmo riciclare o perché il riciclaggio è cattivo.

E il modello ha scritto un saggio convincente su perché il riciclaggio fosse cattivo. Io e Leandro stavamo lavorando in una startup in quel momento e l’ho stampato e l’ho appeso proprio sopra il bidone della raccolta differenziata come uno scherzo. E la gente diceva, “Wow, chi lo ha scritto?” e io dicevo, “Un algoritmo”.

Credo che ci sia qualcosa di stranamente umano, giusto? Quando vediamo del testo generato, ci sorprendiamo di più quando sembra qualcosa che io (o un altro essere umano) potrebbe aver scritto rispetto ad altre applicazioni che stanno accadendo, come la classificazione del testo o compiti più convenzionali.

È incredibile. Mi ricordo quando hanno pubblicato quegli esempi per GPT-2, e uno dei miei preferiti (che mi ha quasi dato questa sensazione di, uff, non siamo ancora del tutto lì) erano alcune delle menzioni più inesatte come “incendi sott’acqua”.

Lewis: Esatto!

Britney: Ma poi è successo qualcosa l’anno successivo con una fuoriuscita di petrolio, dove ci sono stati effettivamente degli incendi sott’acqua! E ho immediatamente pensato a quel testo e ho pensato, forse l’IA è già su qualcosa di cui non siamo ancora del tutto consapevoli?

Tu e altri esperti di Hugging Face avete lavorato duramente sul Corso di Hugging Face. Come è nato e quale è la sua direzione?

Lewis: Quando sono entrato in Hugging Face, Sylvian e Lysandre, due dei principali manutentori della libreria transformers, stavano sviluppando un corso per colmare il divario tra le persone che sono più come ingegneri del software curiosi sull’elaborazione del linguaggio naturale, ma in particolare curiosi sulla rivoluzione dei transformers che sta avvenendo. Quindi ho lavorato con loro e con altri nel team open-source per creare un corso gratuito chiamato il Corso di Hugging Face. E questo corso è progettato per aiutare davvero le persone a passare dal conoscere poco di ML fino ad acquisire la capacità di addestrare modelli su molte diverse attività.

E, abbiamo rilasciato due parti di questo corso e stiamo pianificando di rilasciare la terza parte quest’anno. Sono davvero entusiasta della prossima parte che stiamo sviluppando in questo momento, dove esploreremo diverse modalità in cui i transformers sono davvero potenti. La maggior parte delle volte pensiamo ai transformers per il NLP, ma è probabile che ci sia stata questa esplosione in cui i transformers vengono utilizzati in cose come l’audio o la computer vision e li esamineremo in dettaglio.

Quali sono alcune applicazioni dei transformers che ti entusiasmano?

Lewis: Quella che è un po’ divertente è che nel corso dello scorso anno abbiamo avuto un evento in cui abbiamo coinvolto le persone della comunità nell’utilizzare il materiale del corso per creare applicazioni.

E uno dei partecipanti a questo evento ha creato un generatore di lettere di presentazione per i lavori. Quindi l’idea è che quando ti candidi per un lavoro c’è sempre questa cosa fastidiosa che devi scrivere una lettera di presentazione ed è sempre un po’ come dover essere spiritosi. Quindi questo ragazzo ha creato un generatore di lettere di presentazione in cui fornisci alcune informazioni su te stesso e poi le genera da quelle informazioni.

E in effetti l’ha usato per candidarsi alla Hugging Face.

Davvero?!

Lewis: Sta entrando a far parte del team di Big Science come stagista. Quindi. Voglio dire che questa è una cosa super figa, giusto? Quando impari qualcosa e poi usi quella cosa per candidarti, cosa che ho trovato davvero fantastica.

Dove vorresti vedere più applicazioni di machine learning?

Lewis: Personalmente, penso che l’area che mi entusiasma di più sia l’applicazione dell’apprendimento automatico nelle scienze naturali. E questo è in parte a causa del mio background. Ero un fisico in una vita precedente, ma penso che ciò che è anche molto eccitante qui è che in molti campi. Ad esempio, in fisica o chimica, si conoscono già le leggi fondamentali in termini di equazioni che si possono scrivere, ma si scopre che molti dei problemi che si desidera studiare richiedono spesso una simulazione. O spesso richiedono supercomputer molto potenti per comprendere e risolvere queste equazioni. E una delle cose più entusiasmanti per me è la combinazione di apprendimento profondo con le conoscenze precedenti che gli scienziati hanno raccolto per fare progressi che non erano precedentemente possibili.

E penso che un ottimo esempio sia il modello Alpha Fold di DeepMind per la predizione della struttura delle proteine, in cui sono stati utilizzati una combinazione di transformers con alcune informazioni aggiuntive per generare previsioni di proteine che penso in precedenza richiedevano mesi e ora possono farle in giorni.

Questo accelera l’intero campo in modo davvero potente. E posso immaginare che queste applicazioni conducano in definitiva a una spero migliore futuro per l’umanità.

Come vedi l’evoluzione del mondo della valutazione dei modelli?

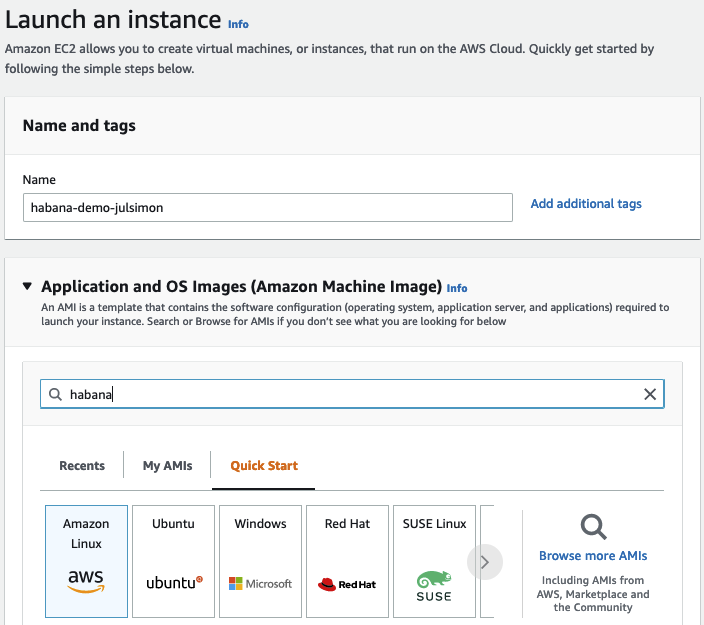

Lewis: Questa è una domanda interessante. Quindi da parte di Hugging Face, una delle cose su cui ho lavorato è stata cercare di costruire l’infrastruttura e gli strumenti che consentano quella che chiamiamo ‘valutazione su larga scala’. Potresti sapere che l’Hugging Face Hub ha migliaia di modelli e dataset. Ma se stai cercando di orientarti in questo spazio potresti chiederti, ‘Sono interessato alla risposta alle domande e voglio sapere quali sono i primi 10 modelli per questa particolare attività’.

E al momento, è difficile trovare la risposta a questa domanda, non solo sull’Hu, ma in generale nello spazio dell’apprendimento automatico questo è abbastanza difficile. Spesso devi leggere articoli e poi devi prendere quei modelli e testarli tu stesso manualmente e questo è molto lento e inefficiente.

Quindi una cosa su cui abbiamo lavorato è sviluppare un modo in cui è possibile valutare modelli e dataset direttamente tramite l’Hu. Stiamo ancora cercando di sperimentare in quella direzione. Ma spero di avere qualcosa di interessante da mostrare più avanti quest’anno.

E c’è un altro aspetto di questo che è che una grande parte della misurazione del progresso nell’apprendimento automatico avviene attraverso l’uso di benchmark. Questi benchmark sono tradizionalmente un insieme di dataset con alcune attività, ma ciò che potrebbe mancare è che molti ricercatori ci dicono: “Ehi, ho questa idea interessante per un benchmark, ma non voglio davvero implementare tutta l’infrastruttura dettagliata per le sottomissioni e la manutenzione e tutte quelle cose”.

Quindi abbiamo lavorato con alcuni partner davvero interessanti per ospitare i benchmark direttamente sull’Hu. In modo che poi le persone della comunità di ricerca possano utilizzare gli strumenti che abbiamo e semplificare la valutazione di questi modelli.

Questo è davvero interessante e potente.

Lewis: Forse una cosa da menzionare è che l’intera questione della valutazione è molto sottile. Sappiamo da precedenti benchmark, come SQuAD, un famoso benchmark per misurare quanto sono bravi i modelli nel rispondere alle domande, che molti di questi modelli trasformatore sono bravi a prendere scorciatoie.

Bene, quello è l’obiettivo, ma si scopre che molti di questi modelli trasformatore sono davvero bravi a prendere scorciatoie. Quindi, quello che stanno effettivamente facendo è ottenere un punteggio molto alto su un benchmark che non necessariamente si traduce nella cosa reale di cui eri interessato, ovvero rispondere alle domande.

E ci sono tutte queste modalità di fallimento sottili in cui i modelli potrebbero fornire risposte completamente sbagliate o non dovrebbero rispondere affatto. E quindi al momento nella comunità di ricerca c’è una discussione molto attiva e vigorosa su quale ruolo svolgono i benchmark nel modo in cui misuriamo il progresso.

Ma anche, come codificano questi benchmark i nostri valori come comunità? E una cosa che penso che Hugging Face possa davvero offrire alla comunità qui è il mezzo per diversificare lo spazio dei valori perché tradizionalmente la maggior parte di questi articoli di ricerca provengono dagli Stati Uniti, che è un grande paese ma è solo una piccola parte dell’esperienza umana, giusto?

Quali sono alcuni errori comuni che gli ingegneri o le squadre di machine learning commettono?

Lewis: Posso dirti forse quelli che ho fatto io.

Probabilmente una buona rappresentazione del resto delle cose. Quindi penso che la lezione più grande che ho imparato quando ho iniziato nel campo è utilizzare modelli di base all’inizio. È un problema comune che ho fatto e poi ho visto fare ad altri ingegneri junior è cercare il modello più avanzato e di ultima generazione.

Anche se potrebbe funzionare, molte volte quello che succede è che introduci molta complessità nel problema e il tuo modello di ultima generazione potrebbe avere un bug e non saprai davvero come risolverlo perché il modello è così complesso. È un modello molto comune nell’industria e soprattutto nell’NLP, che puoi effettivamente ottenere buoni risultati con espressioni regolari e modelli lineari come la regressione logistica e queste cose ti daranno un buon punto di partenza. Poi, se puoi costruire un modello migliore, fallo, ma è importante avere un punto di riferimento.

E poi penso che la seconda grande lezione che ho imparato dalla costruzione di molti progetti è che puoi diventare un po’ ossessionato dalla parte di modellazione del problema perché quella è la parte eccitante quando fai machine learning, ma c’è tutto questo ecosistema. Specialmente se lavori in un’azienda grande, ci sarà tutto questo ecosistema di servizi e cose che ruotano attorno alla tua applicazione.

Quindi la lezione qui è che dovresti cercare realmente di costruire qualcosa dall’inizio alla fine che magari non ha nemmeno alcun machine learning. Ma è la struttura portante su cui puoi costruire il resto del sistema perché potresti passare tutto questo tempo ad allenare un modello fantastico e poi scopri, oh, oops.

Non si integra con i requisiti che abbiamo nella nostra applicazione. E allora hai sprecato tutto questo tempo.

Questo è un buon consiglio! Non sovraingegnarti. È qualcosa che cerco sempre di tenere a mente.

Lewis: Esattamente. Ed è una cosa naturale, penso, per gli esseri umani, specialmente se sei un fanatico di trovare il modo più interessante per fare qualcosa e nella maggior parte dei casi, semplice è meglio.

Se potessi tornare indietro e fare una cosa diversamente all’inizio della tua carriera nell’apprendimento automatico, cosa sarebbe?

Lewis: Oh, wow. Questa è una domanda difficile. Hmm. La ragione per cui è davvero difficile rispondere a questa domanda è che ora che lavoro per Hugging Face, è il tipo di lavoro più gratificante che abbia mai fatto nella mia vita. E la domanda è se avessi cambiato qualcosa quando ho iniziato, forse non sarei qui, giusto?

È una di quelle cose in cui è una questione complicata in quel senso. Suppongo che una cosa che avrei potuto fare leggermente diversamente è quando ho iniziato a lavorare come data scientist, tendi a sviluppare le competenze che riguardano il collegamento dei problemi aziendali ai problemi software o, in definitiva, ai problemi di apprendimento automatico.

E questa è una competenza davvero fantastica da avere. Ma ciò che ho scoperto in seguito è che la mia vera passione è lo sviluppo di software open source. Quindi probabilmente la cosa che avrei fatto diversamente sarebbe stata iniziare molto prima. Perché alla fine la maggior parte dell’open source è davvero guidata dai membri della comunità.

Quindi avrebbe potuto essere un modo per abbreviare il mio percorso per fare questo a tempo pieno.

Amo l’idea che se avessi fatto qualcosa di diverso forse non saresti da Hugging Face.

Lewis: È come il film dell’effetto farfalla, giusto? Torni indietro nel tempo e poi non hai più gambe o qualcosa del genere.

Assolutamente. Non voglio rovinare un buon affare!

Lewis: Esattamente.

Domande rapide:

Miglior consiglio per qualcuno che vuole avvicinarsi all’intelligenza artificiale/machine learning?

Lewis: Inizia semplicemente. Inizia a programmare. Inizia a contribuire se vuoi fare open source. Puoi sempre trovare delle ragioni per non farlo, ma devi solo sporcarti le mani.

Quali sono alcuni dei settori di cui sei più eccitato di vedere l’applicazione del machine learning?

Lewis: Come ho detto prima, penso che le scienze naturali siano l’area che mi entusiasma di più

È qui che penso che sia più eccitante. Se guardiamo ad esempio il lato industriale, penso che lo sviluppo di nuovi farmaci tramite il machine learning sia molto interessante. Personalmente, sarei davvero felice se ci fossero progressi nella robotica in cui potrei finalmente avere un robot per piegare la mia biancheria perché odio davvero farlo e sarebbe bello se ci fosse un modo automatizzato per gestirlo.

Le persone dovrebbero aver paura che l’IA prenda il controllo del mondo?

Lewis: Forse. È una questione difficile perché penso che abbiamo motivi per pensare che potremmo creare sistemi abbastanza pericolosi nel senso che potrebbero essere utilizzati per causare molti danni. Un’analogia è forse con le armi che puoi usare nello sport come il tiro con l’arco e il tiro a segno, ma che puoi anche usare in guerra. Un grande rischio è probabilmente se pensiamo di combinare queste tecniche con il settore militare, questo potrebbe portare a situazioni complesse.

Ma non sono molto preoccupato del Terminator. Sono più preoccupato, non so, di un agente fuorilegge sul mercato azionario finanziario che fallisce l’intero mondo.

È un ottimo punto.

Lewis: Scusate, è un po’ cupo.

No, è stato grande. La domanda successiva è un seguito sul tuo robot per piegare la biancheria. Quando gli robot assistiti dall’IA saranno presenti in tutte le case?

Lewis: Risposta onesta. Non lo so. Tutti quelli che conosco che lavorano sulla robotica dicono che questo è ancora un compito estremamente difficile nel senso che la robotica non ha vissuto le stesse rivoluzioni che l’NLP e il deep learning hanno avuto. Ma d’altra parte, si possono vedere alcuni sviluppi molto interessanti nell’ultimo anno, specialmente intorno all’idea di poter trasferire conoscenze da una simulazione al mondo reale.

Credo che ci sia speranza che nella mia vita avrò un robot per piegare la biancheria.

A cosa sei stato interessato ultimamente? Potrebbe essere un film, una ricetta, un podcast, letteralmente qualsiasi cosa. E sono solo curioso di cosa sia e come qualcuno interessato potrebbe trovarlo o iniziare.

Lewis: È una grande domanda. Per me, mi piacciono i podcast in generale. È il mio nuovo modo di leggere libri perché ho un bambino piccolo, quindi faccio le faccende di casa e ascolto allo stesso tempo.

Un podcast che si distingue molto di recente è in realtà il podcast di DeepMind prodotto da Hannah Fry, una matematica nel Regno Unito, che offre un bellissimo percorso non solo su ciò che fa DeepMind, ma più in generale su ciò che fa l’apprendimento profondo e in particolare l’apprendimento per rinforzo e come stanno influenzando il mondo. Ascoltare questo podcast è come ascoltare un documentario della BBC perché l’inglese ha un accento fantastico e ti senti davvero ispirato perché gran parte del lavoro di cui parla in questo podcast ha una forte sovrapposizione con ciò che facciamo noi a Hugging Face. Vedi questa visione più ampia di cercare di spianare la strada per un futuro migliore.

Ha colpito molto. E mi piace molto perché le spiegazioni sono super chiare e puoi condividerle con la tua famiglia e i tuoi amici e dire: “Ehi, se vuoi sapere cosa sto facendo? Questo può darti un’idea approssimativa”.

Ti offre una visione molto interessante dei ricercatori di DeepMind e della loro storia.

Sicuramente lo ascolterò. [Aggiornamento: È uno dei miei nuovi podcast preferiti. 🙂 Grazie, Lewis!]

Quali sono alcuni dei tuoi paper preferiti sull’apprendimento automatico?

Lewis: Dipende da come misuriamo questo, ma c’è un paper che mi colpisce particolarmente, che è abbastanza vecchio. È dello stesso creatore delle foreste casuali, Leo Breiman. Le foreste casuali sono una tecnica molto famosa di apprendimento automatico classico che è utile per i dati tabulari che si trovano nell’industria e ho dovuto insegnare le foreste casuali all’università un anno fa.

E ho pensato, ok, leggerò questo paper degli anni 2000 e vedrò se lo capisco. Ed è un modello di chiarezza. È molto breve e spiega molto chiaramente come l’algoritmo viene implementato. Puoi praticamente prendere questo paper e implementare il codice molto molto facilmente. E questo per me è stato un bell’esempio di come i paper venivano scritti nei tempi medievali.

Mentre al giorno d’oggi, la maggior parte dei paper ha un approccio formulistico del tipo: ok, ecco un’introduzione, ecco una tabella con alcuni numeri che migliorano e ecco una sezione su qualche lavoro correlato a caso. Quindi, penso che questo sia uno che mi colpisce molto.

Ma un altro che è un po’ più recente è un paper di nuovo di DeepMind sull’utilizzo di tecniche di apprendimento automatico per dimostrare teoremi fondamentali come la topologia algebrica, che è un ramo speciale di matematica astratta. E in un certo periodo della mia vita, ho lavorato su questi argomenti correlati.

Quindi, per me, è una prospettiva molto eccitante quella di arricchire le conoscenze che un matematico avrebbe nel tentativo di restringere lo spazio dei teoremi che potrebbero dover cercare. Penso che questo per me sia stato sorprendente perché molte volte sono stato piuttosto scettico sul fatto che l’apprendimento automatico porti a questa comprensione scientifica fondamentale al di là di quelle ovvie come fare previsioni.

Ma questo esempio ha mostrato che puoi effettivamente essere molto creativo e aiutare i matematici a trovare nuove idee.

Qual è il significato della vita?

Lewis: Penso che la risposta onesta sia che non lo so. E probabilmente chiunque ti dia una risposta probabilmente sta mentendo. Questo è un po’ sarcastico. Non lo so, suppongo che essere uno scienziato del sito per formazione e specialmente un fisico, sviluppi questa visione del mondo che è molto basata sul fatto che non c’è davvero un significato più profondo in questo.

È molto come se l’universo fosse abbastanza casuale e suppongo che l’unica cosa che puoi trarre da questo oltre ad essere molto tristi sia che tu derivi il tuo proprio significato, giusto? E nella maggior parte dei casi questo deriva sia dal lavoro che fai che dalla famiglia o dagli amici che hai.

Ma penso che quando trovi un modo per derivare il tuo proprio significato e scopri che ciò che fai è effettivamente interessante e significativo, quella è la parte migliore. La vita è molto alti e bassi, giusto? Almeno per me personalmente, le cose che sono sempre state molto significative sono generalmente quelle che creano qualcosa. Quindi, ero un musicista, quindi era un modo di creare musica per altre persone e c’era grande piacere nel farlo. E ora, in un certo senso, creo codice che è una forma di creatività.

Assolutamente. Penso che sia bello, Lewis! C’è qualcos’altro che vorresti condividere o menzionare prima di concludere?

Lewis: Forse acquista il mio libro.

È così buono!

Lewis: [mostra il libro con un pappagallo sulla copertina] Conosci la storia del pappagallo?

Non credo.

Lewis: Quindi quando O’Reilly ti dice “Andremo a far disegnare la copertina dal nostro illustratore”, è un segreto, giusto?

Non ti dicono qual è la logica o non hai voce in capitolo. Quindi, in pratica, l’illustratore propone un’idea e in uno degli ultimi capitoli del libro abbiamo una sezione in cui addestriamo un modello simile a GPT-2 sul codice Python, questa era l’idea di Thom, e ha deciso di chiamarlo code parrot.

Penso che l’idea o lo scherzo che aveva fosse che c’è molta discussione nella comunità su questo articolo su cui hanno lavorato Meg Mitchell e altri chiamato ‘Stochastic Parrots’. E l’idea era che hai questi modelli di linguaggio molto potenti che sembrano mostrare tratti simili a quelli umani nella loro scrittura come abbiamo discusso in precedenza, ma in fondo forse stanno solo facendo qualche tipo di cosa simile all’educazione di un pappagallo.

Sai, se parli con un cacatua, ti insulterà o farà battute. Questo potrebbe non essere una vera misura di intelligenza, giusto? Quindi penso che l’illustratore abbia visto qualcosa del genere e abbia deciso di mettere un pappagallo, che secondo me è una metafora perfetta per il libro.

E il fatto che ci siano dei trasformatori al suo interno.

Non sapevo che fosse questo il metodo per creare le copertine di O’Reilly. Non te lo dicono, semplicemente traggono il contesto dal libro e creano qualcosa?

Lewis: Sembra proprio così. Voglio dire, non conosciamo davvero il processo. Sto solo supponendo che forse l’illustratore stesse cercando un’idea e ha visto alcuni animali nel libro. In uno dei capitoli parliamo di giraffe e zebre e roba del genere. Ma sì, sono contento della copertina col pappagallo.

Mi piace. Beh, sembra assolutamente stupendo. Molti di questi tipi di libri tendono ad essere abbastanza secchi e tecnici e questo invece sembra quasi una narrazione mista a informazioni tecniche applicabili, che è bello.

Lewis: Grazie. Sì, è una cosa che abbiamo capito dopo perché era la prima volta che scrivevamo un libro e pensavamo che dovremmo essere seri, giusto? Ma se mi conosci un po’, sai che non sono mai veramente serio per niente. E guarda indietro, avremmo dovuto essere ancora più sciocchi nel libro.

Dovevo controllare il mio umorismo in vari punti, ma forse ci sarà una seconda edizione un giorno e allora potremo semplicemente infilarci dei meme.

Per piacere, ti attendo con ansia!

Lewis: In effetti, c’è un meme nel libro. Abbiamo cercato di farlo passare inosservato all’editore e abbiamo il cane DOGE all’interno del libro e usiamo un trasformatore di visione speciale per cercare di classificare che meme è.

Sono così contento che l’abbiate inserito. Ben fatto! Non vedo l’ora di tanti altri nella prossima edizione. Grazie mille per avermi tenuto compagnia oggi. Apprezzo davvero. Dove possono i nostri ascoltatori trovarti online?

Lewis: Sono abbastanza attivo su Twitter. Puoi trovarmi con il mio nome utente @_lewtun. LinkedIn è un posto strano e non ci sono molto spesso. E naturalmente c’è Hugging Face, i forum di Hugging Face e Discord.

Perfetto. Grazie mille, Lewis. E ci parleremo presto!

Lewis: Ciao, Britney. Ciao.

Grazie per aver ascoltato gli esperti di Machine Learning!