Cos’è MetaGPT? Agenti LLM che collaborano per risolvere compiti complessi.

Cos'è MetaGPT? Agenti LLM che risolvono compiti complessi.

Pubblicato originariamente su louisbouchard.ai, leggilo 2 giorni prima sul mio blog!

Guarda il video!

Grazie a GPT e ai recenti modelli di linguaggio di grandi dimensioni, abbiamo assistito alla popolarizzazione di un nuovo tipo di sistema basato sull’IA… gli agenti. Un agente è essenzialmente un modello di intelligenza artificiale come ChatGPT che può accedere e interagire con una o più applicazioni. Immagina di chiedere a ChatGPT di creare una presentazione PowerPoint per te. Ma l’intera cosa, non solo il testo su ogni diapositiva. Anche la disposizione e le immagini. È una sorta di imitazione di un essere umano per un compito specifico anziché essere limitato al testo. Per fare ciò, l’agente deve capire il software e interagire con esso in qualche modo, sia attraverso i comandi di testo, se possibile, o con la generazione di codice.

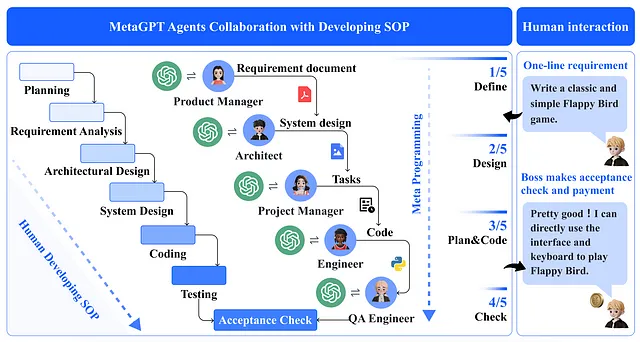

Un agente può diventare piuttosto potente quando lo si combina correttamente con un software o un’applicazione, ma ancora più potente è combinare più agenti di questo tipo, permettendoti di completare compiti molto più complessi come la creazione di un intero videogioco, dall’ideazione dell’idea alla progettazione dei diversi livelli, difficoltà, codice e test di controllo qualità, dove un agente sarebbe responsabile di ciascuno di questi compiti. Molti di questi sistemi che richiedono solo un prompt iniziale come “creami un gioco simile a Flappy Bird” esistono già, come Auto-GPT, BabyAGI o AgentGPT, ma hanno un problema comune.

Costruire un sistema così avanzato basato su modelli di linguaggio di grandi dimensioni è sia molto difficile che pericoloso. Uno dei principali problemi è che un modello di linguaggio di grandi dimensioni come ChatGPT è suscettibile di allucinazioni, che si verificano quando il modello produce fatti o informazioni completamente insensati. Poiché abbiamo addestrato il modello di intelligenza artificiale a fornire una risposta a tutte le domande, lo fa anche se non ha la risposta corretta alla tua domanda. E il problema principale è che crede che sia vero, non ha il concetto di mentire o nascondere la verità, semplicemente non lo sa. Puoi vedere come possa diventare un problema per un solo modello di intelligenza artificiale, ma immagina cosa succede se li colleghi insieme senza…