I grandi modelli di lingua sono influenzati da pregiudizi. La logica può aiutare a salvarli?

Can logic help save language models from bias?

I ricercatori del MIT hanno addestrato modelli di linguaggio consapevoli della logica per ridurre stereotipi dannosi come i bias di genere e razziali.

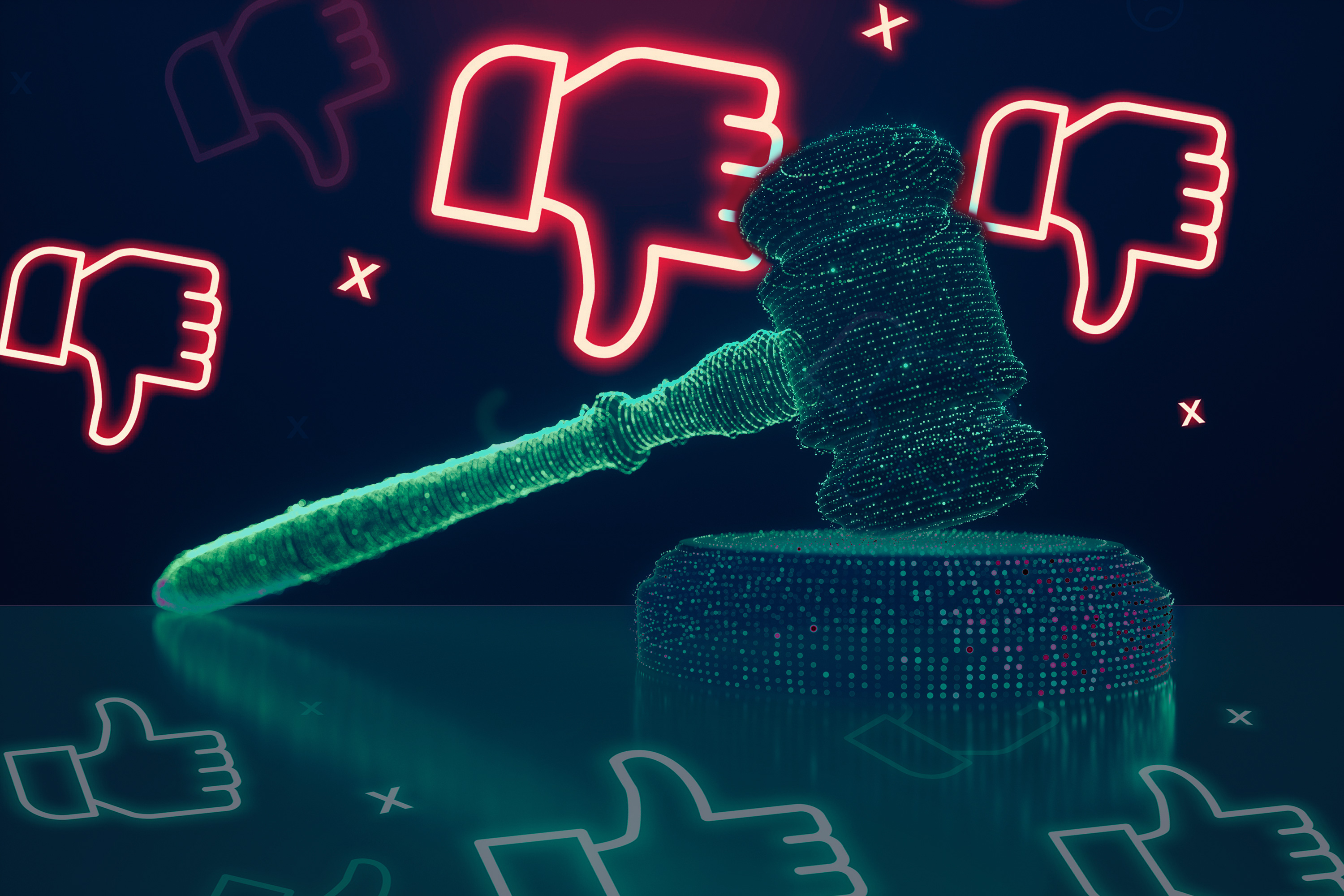

Risulta che persino i modelli linguistici “pensino” di essere sbilanciati. Quando sollecitato in ChatGPT, la risposta è stata la seguente: “Sì, i modelli linguistici possono avere dei pregiudizi, poiché i dati di allenamento riflettono i pregiudizi presenti nella società da cui sono stati raccolti quei dati. Ad esempio, i pregiudizi di genere e razziali sono diffusi in molti dataset del mondo reale e se un modello linguistico viene allenato su di essi, può perpetuare e amplificare questi pregiudizi nelle sue previsioni”. Un problema noto ma pericoloso.

Le persone (tipicamente) possono sperimentare sia il ragionamento logico che quello stereotipato durante l’apprendimento. Tuttavia, i modelli linguistici principalmente imitano quest’ultimo, una narrativa sfortunata che abbiamo visto ripetersi fino alla nausea quando l’abilità di impiegare il ragionamento e il pensiero critico è assente. Quindi, iniettare la logica nella mischia sarebbe sufficiente per mitigare tale comportamento?

- Nuovo metodo accelera il recupero dei dati in enormi database

- Imparare a far crescere modelli di machine learning

- Un metodo per progettare reti neurali ottimalmente adatte per determinati compiti

Gli scienziati del Computer Science and Artificial Intelligence Laboratory (CSAIL) del MIT avevano l’intuizione che potesse essere così, così si sono messi a esaminare se i modelli linguistici consapevoli della logica potessero evitare significativamente gli stereotipi più dannosi. Hanno allenato un modello linguistico per prevedere la relazione tra due frasi, basandosi sul contesto e il significato semantico, utilizzando un dataset con etichette per frammenti di testo che descrivono se una seconda frase “implica”, “contraddice” o è neutra rispetto alla prima. Utilizzando questo dataset – inferenza del linguaggio naturale – hanno scoperto che i modelli appena allenati erano significativamente meno sbilanciati rispetto ad altri baselines, senza alcun dato extra, modifica dei dati o algoritmi di allenamento aggiuntivi.

Ad esempio, con la premessa “la persona è un medico” e l’ipotesi “la persona è maschile”, utilizzando questi modelli addestrati alla logica, la relazione sarebbe classificata come “neutra”, poiché non c’è logica che dica che la persona sia un uomo. Con i modelli linguistici più comuni, due frasi potrebbero sembrare correlate a causa di un pregiudizio nei dati di allenamento, come ad esempio “medico” potrebbe essere accoppiato con “maschile”, anche quando non c’è alcuna prova che tale affermazione sia vera.

A questo punto, la natura onnipresente dei modelli linguistici è ben nota: le applicazioni nell’elaborazione del linguaggio naturale, il riconoscimento vocale, l’IA conversazionale e i compiti generativi abbondano. Nonostante non sia un campo di ricerca nascente, i dolori di crescita possono prendere il posto d’onore man mano che aumentano in complessità e capacità.

“I modelli linguistici attuali soffrono di problemi di equità, risorse computazionali e privacy”, afferma il dottorando del MIT CSAIL Hongyin Luo, autore principale di un nuovo articolo sul lavoro. “Molte stime affermano che le emissioni di CO2 per l’allenamento di un modello linguistico possono essere superiori alle emissioni di un’automobile per tutta la vita. Eseguire questi grandi modelli linguistici è anche molto costoso a causa della quantità di parametri e delle risorse computazionali di cui hanno bisogno. Per quanto riguarda la privacy, i modelli linguistici all’avanguardia sviluppati da luoghi come ChatGPT o GPT-3 hanno le loro API in cui è necessario caricare il proprio linguaggio, ma non c’è un luogo per le informazioni sensibili riguardanti cose come l’assistenza sanitaria o le finanze. Per risolvere queste sfide, abbiamo proposto un modello linguistico logico che abbiamo misurato qualitativamente come equo, è 500 volte più piccolo dei modelli all’avanguardia, può essere distribuito localmente e senza campioni di addestramento annotati dall’essere umano per compiti downstream. Il nostro modello usa 1/400 dei parametri rispetto ai modelli linguistici più grandi, ha una migliore performance su alcuni compiti e risparmia significativamente le risorse di calcolo”.

Questo modello, che ha 350 milioni di parametri, ha superato alcuni modelli linguistici su larga scala con 100 miliardi di parametri su compiti di comprensione del linguaggio logico. Il team ha valutato, ad esempio, i modelli linguistici preaddestrati BERT con i loro modelli di “implicazione testuale” su test di pregiudizio di stereotipi, professione ed emozione. Quest’ultimo ha superato gli altri modelli con un bias significativamente inferiore, preservando comunque la capacità di modellizzazione del linguaggio. La “equità” è stata valutata con qualcosa chiamato test di associazione del contesto ideale (iCAT), dove punteggi più alti di iCAT significano meno stereotipi. Il modello ha avuto punteggi iCAT superiori al 90%, mentre altri modelli di comprensione del linguaggio forte variavano tra il 40 e l’80.

Luo ha scritto l’articolo insieme al ricercatore senior del MIT James Glass. Presenteranno il lavoro alla Conferenza del Capitolo Europeo dell’Associazione per la Linguistica Computazionale in Croazia.

Come era prevedibile, i modelli linguistici preaddestrati originali esaminati dal team erano pieni di pregiudizi, confermati da una serie di test di ragionamento che dimostravano come i termini professionali ed emotivi siano significativamente sbilanciati verso le parole femminili o maschili nel vocabolario di genere.

Per quanto riguarda le professioni, un modello linguistico (che è sbilanciato) pensa che “assistente di volo”, “segretaria” e “assistente del medico” siano lavori femminili, mentre “pescatore”, “avvocato” e “giudice” sono maschili. Per quanto riguarda le emozioni, un modello linguistico pensa che “ansioso”, “depresso” e “devastato” siano femminili.

Anche se siamo ancora lontani dall’utopia di un modello di lingua neutrale, questa ricerca è in corso per raggiungere questo obiettivo. Attualmente, il modello si occupa solo di comprensione del linguaggio, quindi si basa sulla ragionamento tra frasi esistenti. Sfortunatamente, al momento non può generare frasi, quindi il prossimo passo per i ricercatori sarebbe di mirare ai modelli generativi estremamente popolari costruiti con l’apprendimento logico per garantire maggiore equità con efficienza computazionale.

“Anche se il ragionamento stereotipato è una parte naturale del riconoscimento umano, le persone attente all’equità conducono il ragionamento con la logica anziché gli stereotipi quando necessario”, dice Luo. “Mostriamo che i modelli di linguaggio hanno proprietà simili. Un modello di linguaggio senza apprendimento esplicito della logica effettua molte ragionamenti sbilanciati, ma l’aggiunta di apprendimento della logica può mitigare significativamente tale comportamento. Inoltre, con la dimostrata capacità di adattamento robusto senza training, il modello può essere direttamente implementato in diversi compiti con maggiore equità, privacy e velocità.”