Una guida semplice in inglese per invertire l’ingegnerizzazione del codice sorgente di Reddit con LangChain, Activeloop e GPT-4

A simple English guide to reverse engineer Reddit's source code with LangChain, Activeloop, and GPT-4

Immagina di scrivere un software che potrebbe capire, assistere e persino generare codice, simile a quanto farebbe uno sviluppatore esperto.

Bene, tutto questo è possibile con LangChain. Sfruttando modelli avanzati come VectorStores, Conversational RetrieverChain e LLM (Language Model), LangChain ci porta a un nuovo livello di comprensione e generazione del codice.

In questa guida, faremo l’ingegnerizzazione inversa del repository del codice sorgente pubblico di Reddit per la versione 1 del sito, al fine di comprenderne meglio la struttura del codice e fornire approfondimenti sul suo funzionamento interno. Sono stato ispirato a creare questa guida dopo aver letto un tweet di Paul Graham sull’argomento (e perché non so nulla di Lisp, ma volevo comunque capire di cosa stava parlando).

Utilizzeremo la tecnologia di embedding di OpenAI e uno strumento chiamato Activeloop per rendere il codice comprensibile e un LLM (GPT-4 in questo caso) per conversare con il codice. Se sei interessato a utilizzare un altro LLM o una piattaforma diversa, dai un’occhiata alla mia guida precedente sull’ingegnerizzazione inversa dell’algoritmo di Twitter utilizzando DeepInfra e Dolly.

- I Plugin ChatGPT Indispensabili per i Creatori di Contenuti

- Il Potere della Distanza della Conoscenza nell’IA Moderna Colmare il Divario tra Modelli Potenti e Compatti

- Analisi dei sentimenti sulle recensioni degli hotel su TripAdvisor con ChatGPT

Quando avremo finito, saremo in grado di abbreviare il lavoro difficile necessario per comprendere l’algoritmo, chiedendo a un’intelligenza artificiale di fornirci risposte alle nostre domande più urgenti anziché trascorrere settimane a cercare di capirlo da soli. Cominciamo.

Un’outline concettuale per la comprensione del codice con LangChain

LangChain è un potente strumento che può analizzare i repository di codice su GitHub. Riunisce tre parti importanti: VectorStores, Conversational RetrieverChain e un LLM (Language Model) per aiutarti a comprendere il codice, rispondere alle domande su di esso in contesto e persino generare nuovo codice all’interno dei repository di GitHub.

Il Conversational RetrieverChain è un sistema che aiuta a trovare e recuperare informazioni utili da un VectorStore. Utilizza tecniche intelligenti come il filtraggio e il ranking consapevoli del contesto per capire quali frammenti di codice e informazioni sono più rilevanti per la domanda o la query specifica che hai. Ciò che lo distingue è che tiene conto della storia della conversazione e del contesto in cui viene posta la domanda. Ciò significa che può fornirti risultati di alta qualità e rilevanti che affrontano specificamente le tue esigenze. In termini più semplici, è come avere un assistente intelligente che comprende il contesto delle tue domande e ti fornisce le migliori risposte possibili basate su quel contesto.

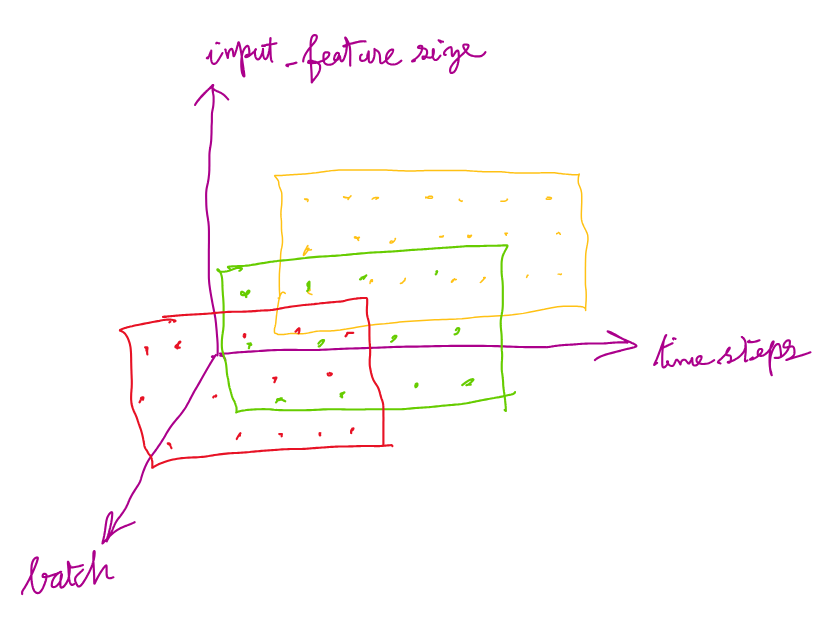

Ora, vediamo il flusso di lavoro di LangChain e come funziona a un alto livello:

- Indicizza la base del codice: Il primo passo è clonare il repository di destinazione che si desidera analizzare. Carica tutti i file all’interno del repository, suddividili in frammenti più piccoli e avvia il processo di indicizzazione. Se disponi già di un dataset indicizzato, puoi persino saltare questo passaggio.

- Embedding e Code Store: Per rendere i frammenti di codice più facilmente comprensibili, LangChain utilizza un modello di embedding consapevole del codice. Questo modello aiuta a catturare l’essenza del codice e memorizza i frammenti di codice incorporati in un VectorStore, rendendoli facilmente accessibili per future query.

- Comprensione delle query: Qui entra in gioco il tuo LLM. Puoi utilizzare un modello come GPT-4 per elaborare le tue query. Il modello viene utilizzato per analizzare le tue query e comprendere il significato dietro di esse, considerando il contesto ed estrarre informazioni importanti. Facendo ciò, il modello aiuta LangChain a interpretare con precisione le tue query e fornirti risultati precisi e rilevanti.

- Costruisci il Retriever: Una volta chiara la tua domanda o query, entra in gioco il Conversational RetrieverChain. Esamina il VectorStore, dove sono memorizzati i frammenti di codice, e trova i frammenti di codice più rilevanti per la tua query. Questo processo di ricerca è molto flessibile e può essere personalizzato per soddisfare le tue esigenze. Hai la possibilità di regolare le impostazioni e applicare filtri specifici alle tue esigenze, garantendo che ottieni i risultati più accurati e utili per la tua query.

- Costruisci la Conversational Chain: Una volta configurato il retriever, è il momento di costruire la Conversational Chain. Questo passaggio implica l’aggiustamento delle impostazioni del retriever per adattarle meglio alle tue esigenze e l’applicazione di eventuali filtri aggiuntivi che potrebbero essere necessari. In questo modo, puoi restringere la ricerca e assicurarti di ricevere i risultati più precisi, accurati e rilevanti per le tue query. Fondamentalmente, ti consente di ottimizzare il processo di recupero per ottenere le informazioni più utili.

- Fai domande: Ora arriva la parte emozionante! Puoi fare domande sul codice utilizzando il Conversational Retrieval Chain. Questo ti fornirà risposte complete e consapevoli del contesto. Il tuo LLM, facendo parte della Conversational Chain, tiene conto dei frammenti di codice recuperati e della storia della conversazione per fornirti risposte dettagliate e precise.

Seguendo questa procedura, sarai in grado di utilizzare efficacemente LangChain per ottenere una comprensione più profonda del codice, ottenere risposte contestuali alle tue domande e persino generare frammenti di codice all’interno dei repository di GitHub. Ora, vediamolo in azione, passo dopo passo.

Guida Passo-Passo

Immergiamoci nell’effettiva implementazione.

1. Ottenere le Chiavi

Per iniziare, dovrai registrarti sui rispettivi siti web e ottenere le chiavi API per Activeloop e OpenAI.

2. Configurare il file indexer.py

Crea un file Python, ad esempio indexer.py, in cui indicizzerai i dati. Importa i moduli necessari e imposta le chiavi API come variabili d’ambiente.

3. Clonare e Indicizzare il Repository Obiettivo

Successivamente, cloneremo il repository dell’algoritmo di Reddit, caricheremo, divideremo e indicheremo i documenti. Puoi clonare l’algoritmo da questo link.

4. Incorporare Frammenti di Codice

Successivamente, utilizziamo le embedding di OpenAI per incorporare i frammenti di codice. Queste embedding vengono quindi memorizzate in un VectorStore, che ci permetterà di eseguire una ricerca di similarità efficiente.

5. Utilizzare GPT-4 per Elaborare e Comprendere le Query degli Utenti

Ora impostiamo un altro file Python, question.py, per utilizzare GPT-4, un modello di linguaggio disponibile con OpenAI, per elaborare e comprendere le query degli utenti.

6. Costruire il Retrieval

Costruiamo un retrieval utilizzando il VectorStore che abbiamo creato in precedenza.

7. Costruire la Conversational Chain

La Conversational Retrieval Chain collega il retrieval e il modello di linguaggio. Ciò consente al nostro sistema di elaborare le query degli utenti e generare risposte consapevoli del contesto.

8. Porre Domande

Ora possiamo porre domande sul codice sorgente di Reddit. Le risposte fornite dalla Conversational Retrieval Chain sono consapevoli del contesto e basate direttamente sulla base di codice.

Ecco alcune delle risposte che ho ottenuto:

Cosa chiederai? Cosa imparerai? Fammi sapere!

Limitazioni

Dopo aver parlato con Shriram Krishnamurthi su Twitter, ho capito che dovrei sottolineare che questo approccio ha alcune limitazioni per la comprensione del codice.

- L’analisi di questo codice può spesso essere incompleta e talvolta potresti perdere dettagli importanti a causa di errori in questa analisi che potrebbero indirizzarti nella direzione sbagliata.

- Potrebbe esserci una certa “inquinamento” dei risultati, che può verificarsi quando il tuo LLM ha conoscenza dei suoi dati di addestramento con termini sovrapposti. Ad esempio, il concetto di “Reddit Karma” è probabilmente già memorizzato nella base di conoscenza di GPT-4, quindi chiedergli come funziona Karma potrebbe portarlo a estrarre contesto dai suoi dati di addestramento invece del codice fornito.

Dovrai esercitare un buon giudizio e adottare un approccio di fiducia ma verifica per questa approccio iniziale approssimativo. Oppure potresti spingerti oltre e costruire un sistema migliore!

Conclusioni

In questa guida, abbiamo esplorato l’ingegnerizzazione inversa del repository del codice sorgente pubblico di Reddit per la versione 1 del sito utilizzando LangChain. Sfruttando le capacità dell’IA, risparmiamo tempo prezioso ed energia, sostituendo l’esame manuale del codice con risposte automatiche alle query.

LangChain è un potente strumento che rivoluziona la comprensione e la generazione del codice. Utilizzando modelli avanzati come VectorStores, Conversational RetrieverChain e un LLM, LangChain permette agli sviluppatori di analizzare in modo efficiente i repository di codice, fornire risposte consapevoli del contesto e generare nuovo codice.

Il workflow di LangChain coinvolge l’indicizzazione della base di codice, l’incorporazione di frammenti di codice, l’elaborazione delle query degli utenti con modelli di linguaggio e l’utilizzo di Conversational RetrieverChain per recuperare frammenti di codice pertinenti. Personalizzando il retrieval e costruendo la Conversational Chain, gli sviluppatori possono perfezionare il processo di recupero per risultati precisi.

Seguendo la guida passo-passo, puoi sfruttare LangChain per migliorare la comprensione del tuo codice, ottenere risposte contestuali e persino generare frammenti di codice all’interno dei repository di GitHub. LangChain apre nuove possibilità per la produttività e la comprensione. Cosa costruirai con esso? Grazie per la lettura!